Предисловие

Возможно, вам интересно, кто мы и почему написали эту книгу.

В последнем издании книги Test-Driven Development with Python (O’Reilly), в конце, Гарри поймал себя на мысли, что задает уйму вопросов по архитектуре. Типа, как лучше всего структурировать приложение, чтобы его было легко тестировать? Это вообще, про что? Может это про покрытие модульными тестами вашей основной бизнес-логики и что бы количество необходимых вам интеграционных и сквозных тестов было минимизировано? Он дал расплывчатые ссылки на «Гексагональную архитектуру», «Порты и адаптеры» и "Functional Core, Imperative Shell", но если бы он был честен, ему пришлось бы признать, что это не то, что он действительно до конца понял, принял или применял на практике.

И тут случилось чудо! Ему посчастливилось столкнуться с Бобом, у которого есть ответы на все эти вопросы.

Боб стал архитектором программного обеспечения, потому что никто из его команды этим не занимался. Оказалось, что он неплохо справлялся с этим, но ему посчастливилось столкнуться с Яном Купером, который научил его новым способам написания кода и мышления в этй области.

Управление Сложностью, Решение Бизнес-Задач

Мы оба работаем в MADE.com, европейской компании электронной коммерции, которая продает мебель онлайн; там мы применяем методы, описанные в этой книге, для создания распределенных систем, моделирующих реальные бизнес-проблемы. Наш пример домена — первая система, созданная Бобом для MADE, и эта книга-попытка записать всё то, чему мы должны научить новых программистов, когда они присоединяются к одной из наших команд.

MADE.com управляет глобальной цепочкой поставок грузов от тоговых партнеров и производителей. В целях сохранения затрат на нзком уровне, мы стараемся оптимизировать доставку запасов на наши склады, чтобы у нас не было непроданных товаров, застрявших на складах.

В идеале диван, который вы хотите купить, прибудет в порт в тот самый день, когда вы решите его купить, и мы отправим его прямо к вам домой, даже не храня. Получение правильного времени — это сложный балансирующий акт, когда товары прибывают на контейнеровозе в течение трех месяцев. По пути вещи ломаются или повреждаются водой, штормы вызывают неожиданные задержки, логистические партнеры неправильно обращаются с товарами, документы пропадают, клиенты меняют свое мнение и изменяют свои заказы и так далее.

Мы решаем эти проблемы, создавая интеллектуальное программное обеспечение, представляющее виды операций, происходящие в реальном мире, чтобы мы могли автоматизировать как можно большую часть бизнеса.

Почему Python?

Если вы читаете эту книгу, то вероятно, не нужно убеждать вас в том, что Python великолепен, поэтому реальный вопрос заключается в следующем: "Зачем сообществу Python нужна такая книга?" Ответ заключается в популярности и зрелости Python: хотя Python, вероятно, является самым быстрорастущим языком программирования в мире и приближается к вершине абсолютной таблицы популярности, он только начинает решать те проблемы, над которыми мир C# и Java работал в течение многих лет. Стартапы становятся реальным бизнесом; веб-приложения и скриптовые автоматизации становятся (говорю шепотом) enterprise software.

В мире Python мы часто цитируем Дзен Python: "Должен существовать один и, желательно, только один очевидный способ сделать это."[2] К сожалению, по мере роста размера проекта наиболее очевидный способ решения задач не всегда помогает вам управлять сложностью и меняющимися требованиями.

Ни один из методов и шаблонов, которые мы обсуждаем в этой книге, не является новым, но по большей части они являются новыми для мира Python. И эта книга не является заменой классики в этой области, такой как Domain-Driven Design Эрика Эванса или Patterns of Enterprise Application Architecture Мартина Фаулера (оба опубликованы Addison-Wesley Professional), на которые мы часто ссылаемся и призываем вас пойти и прочитать.

Но все классические примеры кода в литературе, как правило, написаны на Java или C++/#, и если вы человек из рядов Python и не использовали ни один из этих языков в течение длительного времени (или вообще никогда), то эти листинги кода могут быть довольно…трудными. Видимо это и есть причина, по которой последнее издание другого классического текста, Fowler’s Refactoring (Addison-Wesley Professional), написано в JavaScript.

TDD, DDD, и Event-Driven Architecture

В порядке популярности назовём три инструмента для управления сложностью:

-

Test-driven development (TDD) Разработка на основе тестов. Помогает нам создавать правильный код и проводить рефакторинг или добавлять новые функции, не опасаясь регресса. Но бывает сложно извлечь максимальную пользу из наших тестов: как сделать так, чтобы они выполнялись как можно быстрее? Чтобы мы получили как можно более качественное покрытие и обратную связь от быстрых модульных тестов без зависимостей (dependency-free unit tests) и имели минимальное количество более медленных, нестабильных сквозных (end-to-end) тестов?

-

Domain-driven design (DDD) Разработка на основе поведения. Просит нас сосредоточить наши усилия на построении хорошей модели бизнес-сферы, но как мы можем убедиться, чтобы наши модели не были обременены инфраструктурными проблемами и их не было трудно изменить?

-

Loose coupling Слабосвязанные (микросервисы), интегрированные через сообщения (иногда называемые reactive microservices), являются хорошо зарекомендовавшим себя решением проблемы управления сложностью в нескольких приложениях или бизнес-доменах. Но не всегда очевидно, как сделать так, чтобы они соответствовали широко распространённым инструментам мира Python-Flask, Django, Celery и так далее.

| Не пугайтесь, если вы не работаете с микросервисами (или не заинтересованы в них). Подавляющее большинство моделей, которые мы обсудим, включая большую часть материалов событийной архитектуры, абсолютно применимы в монолитной архитектуре. |

Наша цель в этой книге-представить несколько классических архитектурных моделей и показать, как они поддерживают TDD, DDD и event-driven сервисы. Мы надеемся, что он послужит ориентиром для их реализации в питоническом ключе, и что люди смогут использовать его в качестве первого шага к дальнейшим исследованиям в этой области.

Кому следует прочитать эту книгу

Вот несколько мыслей, которые мы предполагаем справедливо сказать о тебе, дорогой читатель:

-

Ты был близок к некоторым достаточно сложным приложениям Python.

-

Ты видел, а может сам испытал ту боль, которая приходит вместе с попыткой справиться с этой сложностью.

-

Ты не обязательно знаешь что-либо о DDD или любом из классических шаблонов архитектуры приложений.

Мы структурируем наши исследования архитектурных паттернов вокруг примера приложения, выстраивая его главу за главой. Мы используем TDD в работе, поэтому обычно сначала показываем списки тестов, а затем их реализацию. Если вы не привыкли работать с тестом, сначала это может показаться немного странным, но мы надеемся, что вы скоро привыкнете видеть код "используемым" (то есть снаружи), прежде чем увидите, как он построен внутри.

Мы используем некоторые специфические фреймворки и технологии Python, включая Flask, SQLAlchemy и pytest, а также Docker и Redis. Если вы уже знакомы с ними, то это не повредит, но вряд ли это необходимо. Одной из наших главных целей в этой книге является построение архитектуры, для которой конкретные технологические решения становятся второстепенными деталями реализации.

Краткий обзор того, что будет дальше

Книга разделена на две части; Вот некоторые темы, которые мы рассмотрим, и главы, в которых они живут.

#Часть1

- Domain modeling и DDD (Chapters 1, 2 и 7)

-

На каком-то уровне каждый усвоил урок, что сложные бизнес-задачи должны быть отражены в коде, в виде модели предметной области. Но почему всегда кажется, что это так трудно сделать, не запутавшись в инфраструктурных проблемах, наших веб-фреймворках или чем-то еще? В первой главе мы даем широкий обзор domain modeling и DDD, а также показываем, как начать работу с моделью, которая не имеет внешних зависимостей и быстрых модульных тестов. Позже мы вернемся к шаблонам DDD, чтобы обсудить, как выбрать правильный агрегат и как этот выбор связан с вопросами целостности данных.

- Repository, Service Layer, и Unit of Work patterns (Chapters 2, 4, и 5)

-

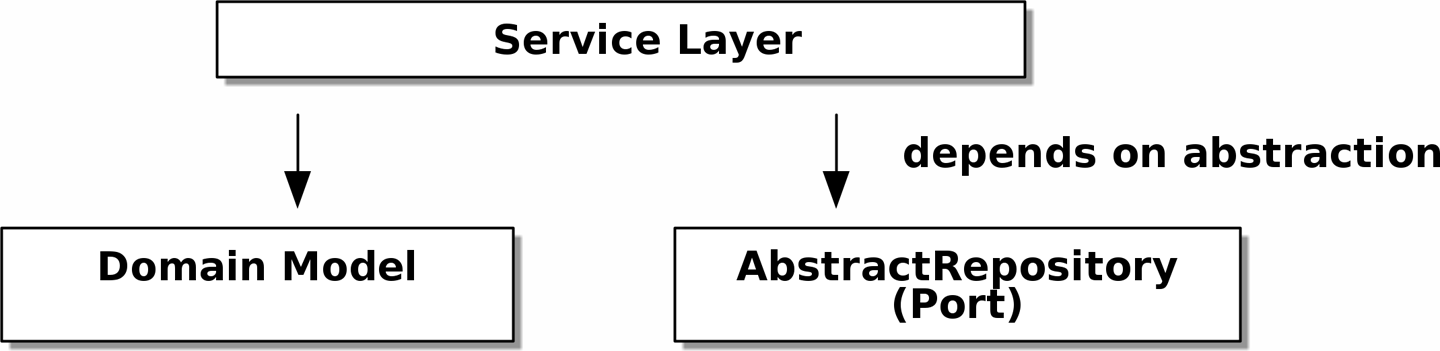

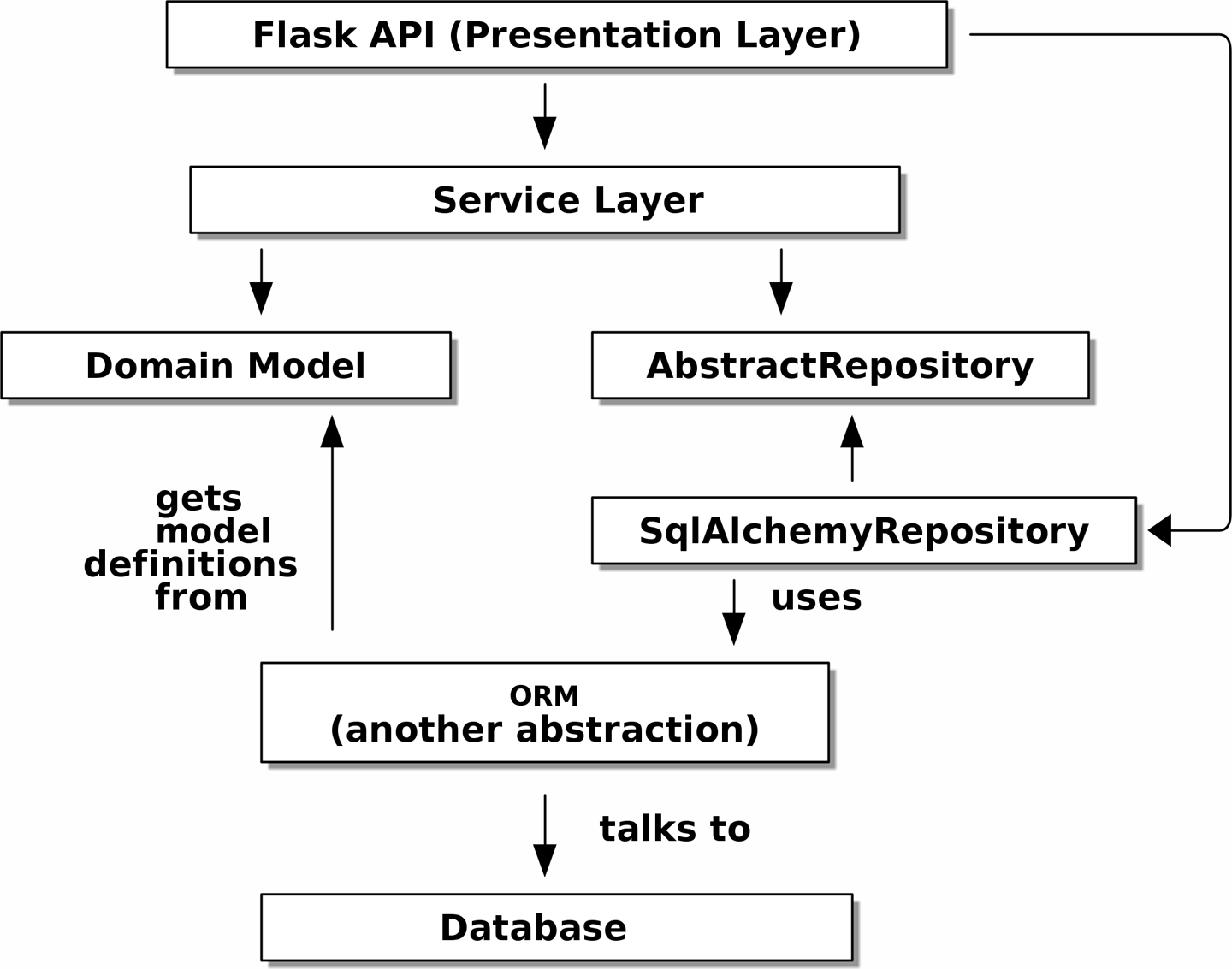

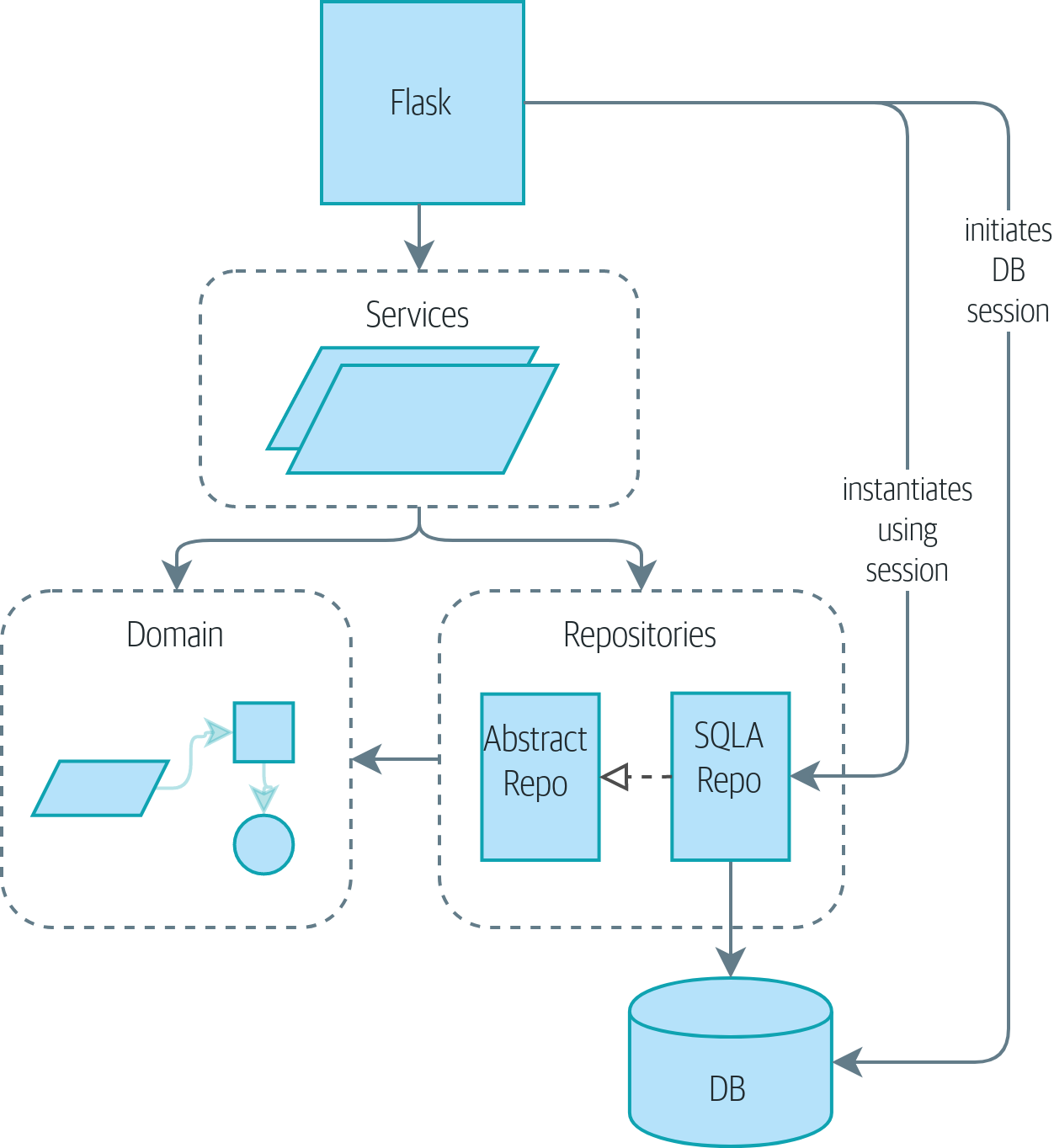

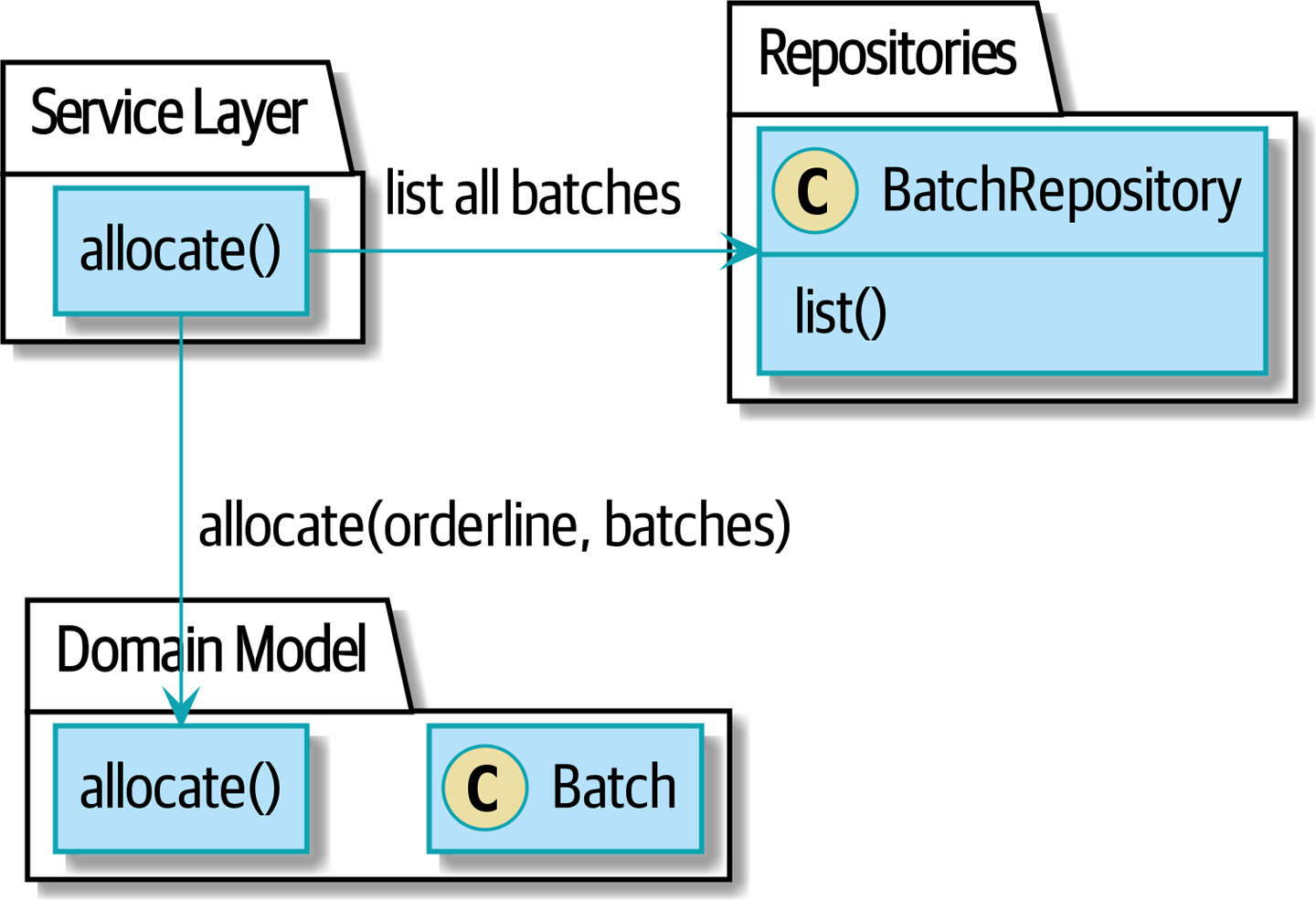

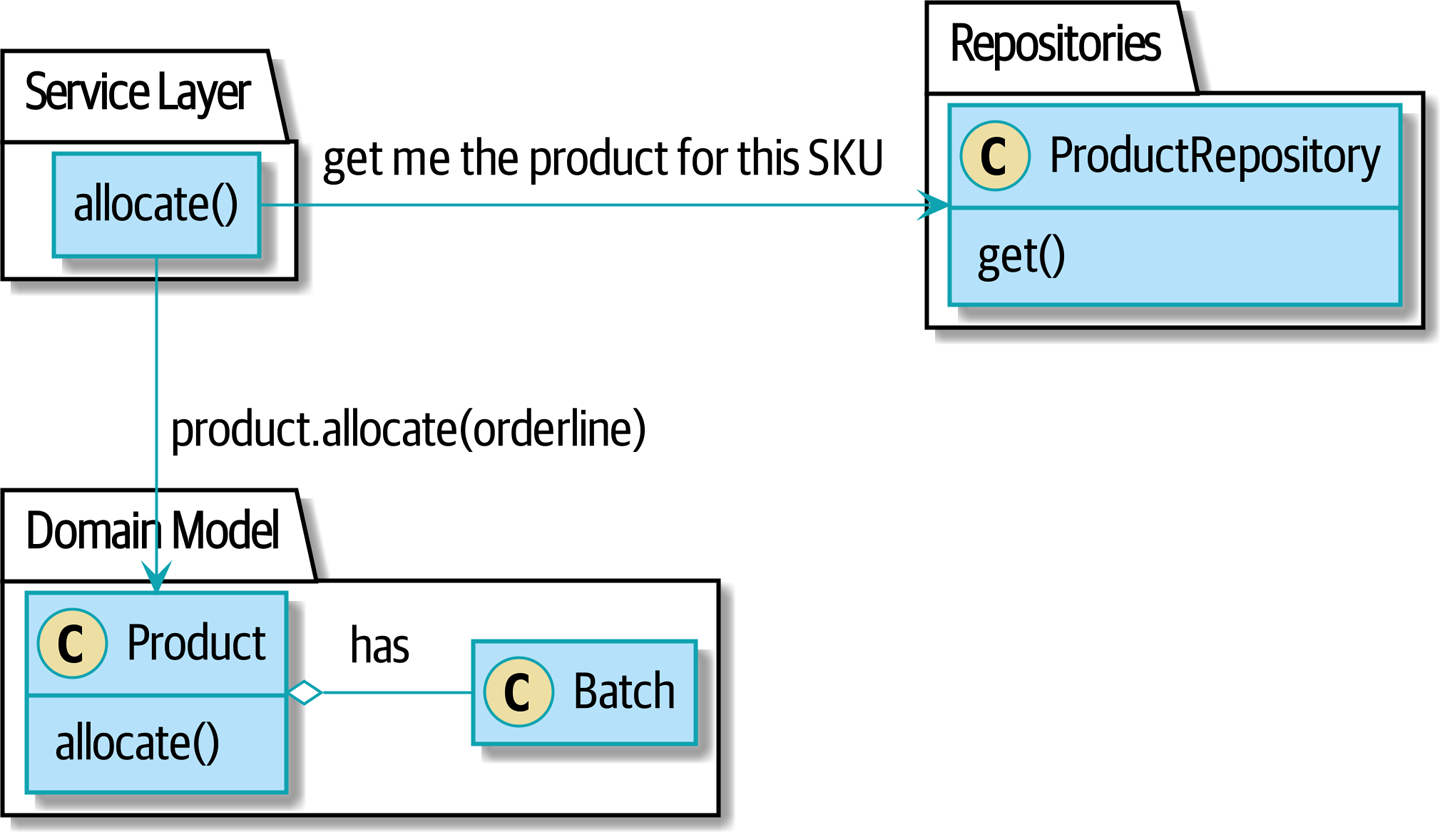

В этих трех главах мы представляем три тесно связанных и взаимно усиливающих друг друга паттерна, которые поддерживают наше стремление сохранить модель свободной от посторонних зависимостей. Мы выстроим слой абстракции вокруг постоянного хранилища, и уровень сервиса, чтобы определить точки входа в нашу систему и захватить основные варианты использования. Мы покажем, как этот слой позволяет легко создавать тонкие точки входа в нашу систему, будь то API Flask или CLI (Command Line Interface - Интерфейс командной строки).

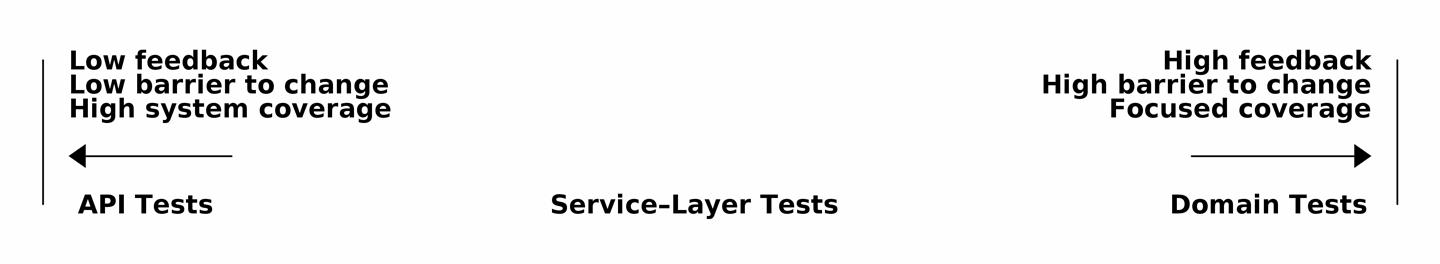

- Некоторые соображения о тестировании и абстракциях (Chapter 3 и 5)

-

После представления первой абстракции (паттерна Repository) воспользуемся возможностью для общего обсуждения того, как выбирать абстракции и какова их роль в выборе того, как наше программное обеспечение связано друг с другом. После знакомства с шаблоном Service Layer, немного поговорим о построении test pyramid и написании модульных тестов на максимально возможном уровне абстракции.

#Часть2

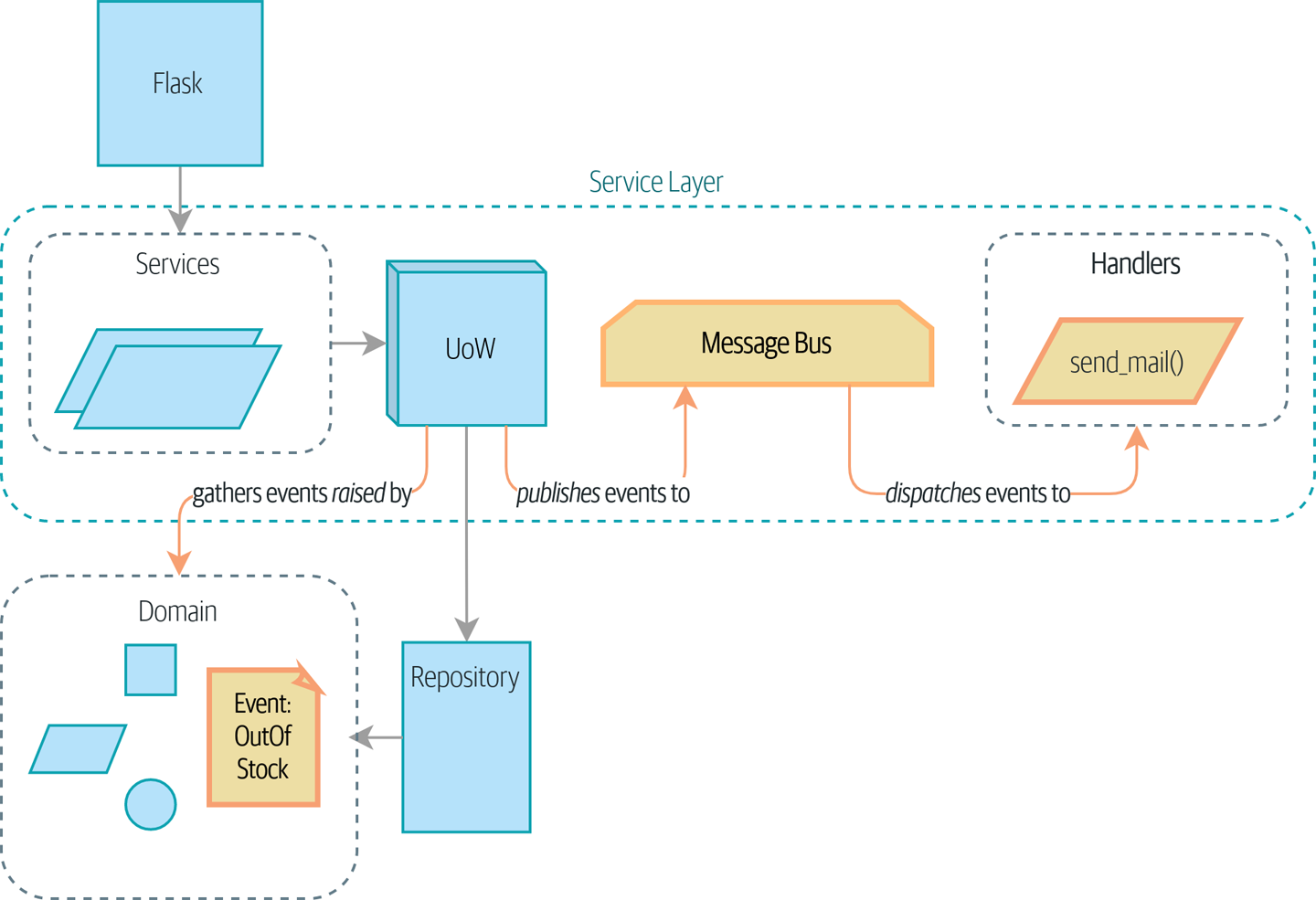

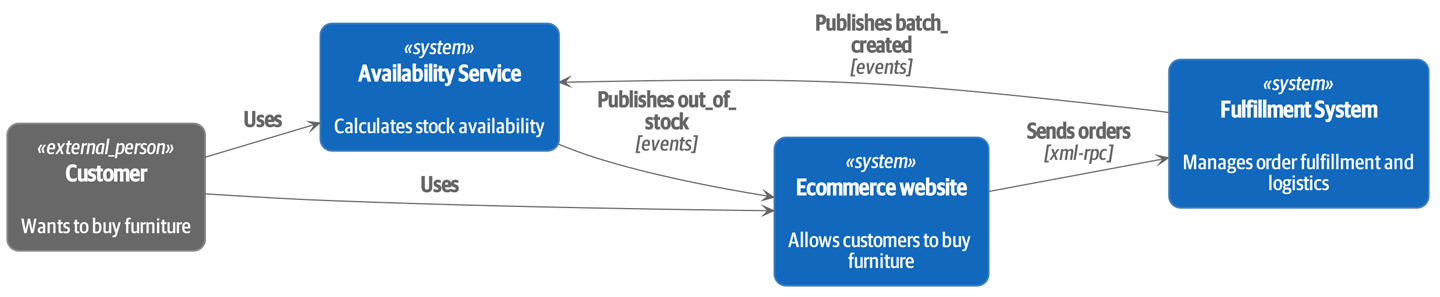

- Архитектура, управляемая событиями (Chapters 8-11)

-

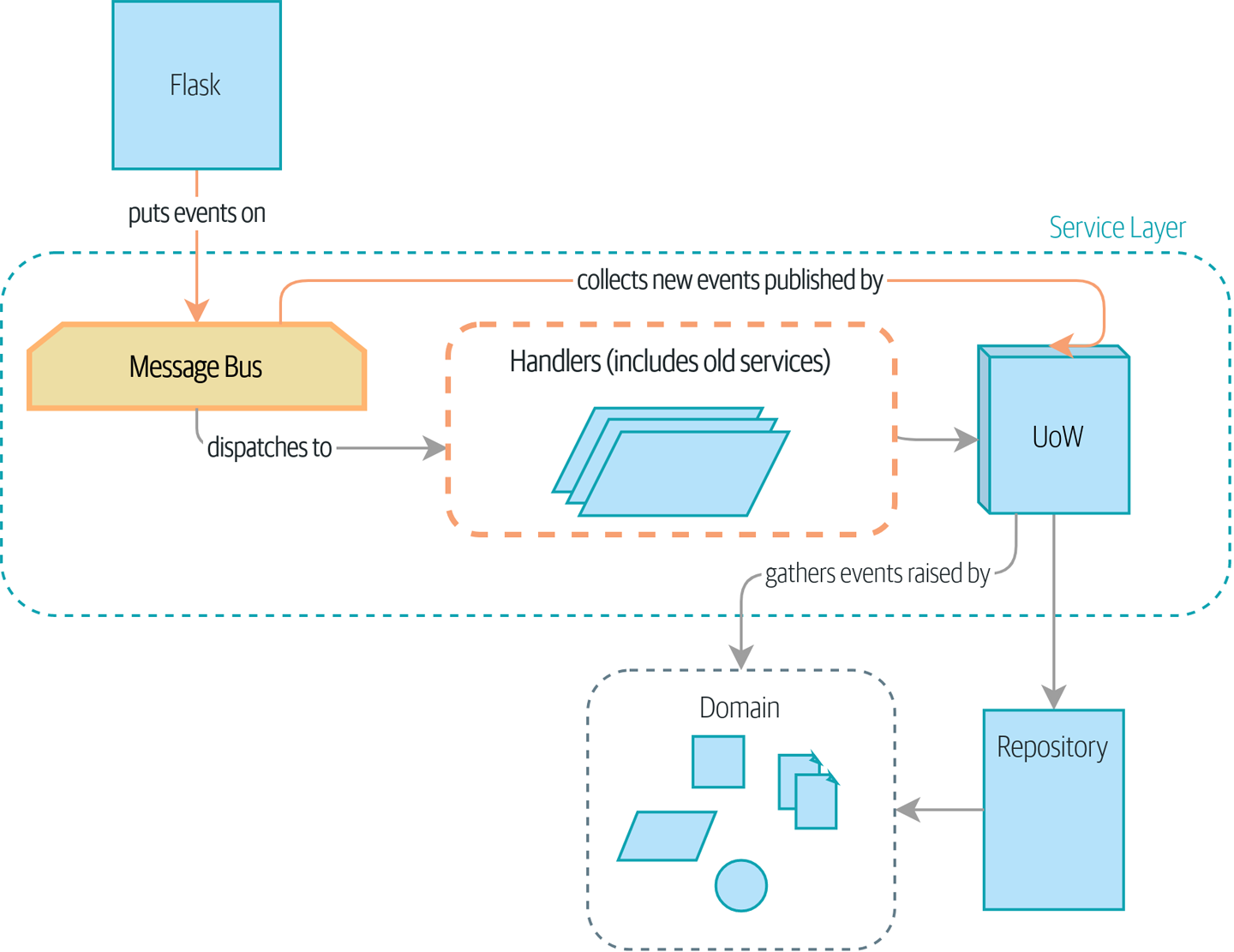

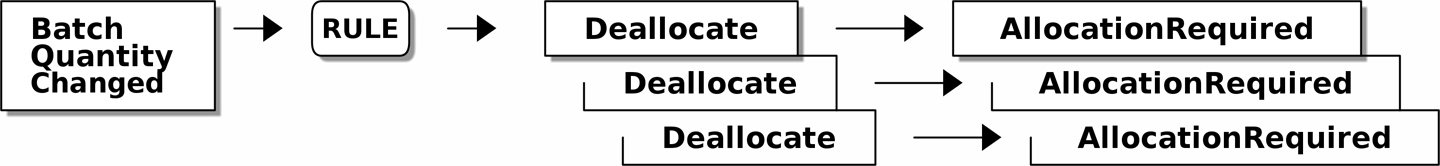

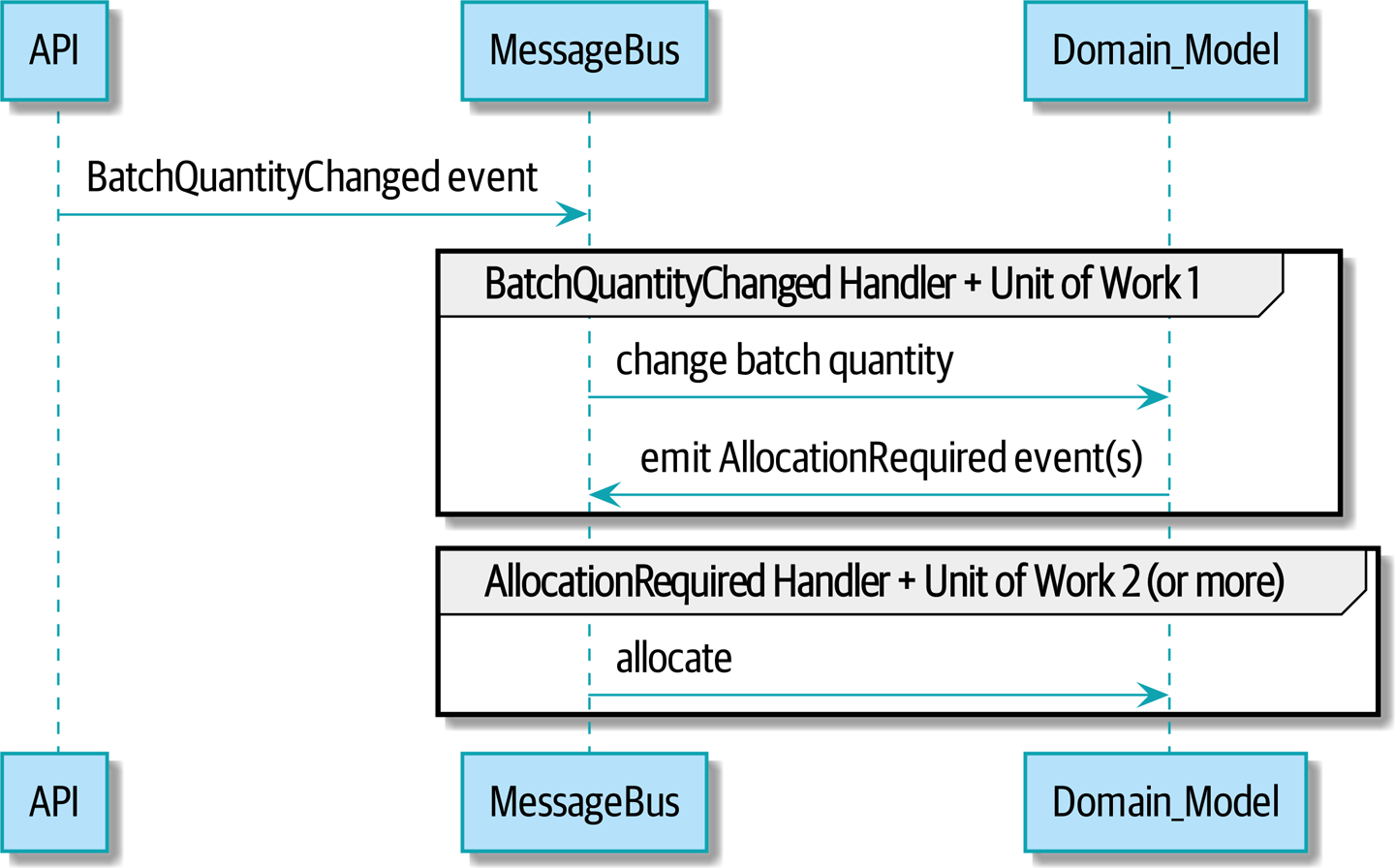

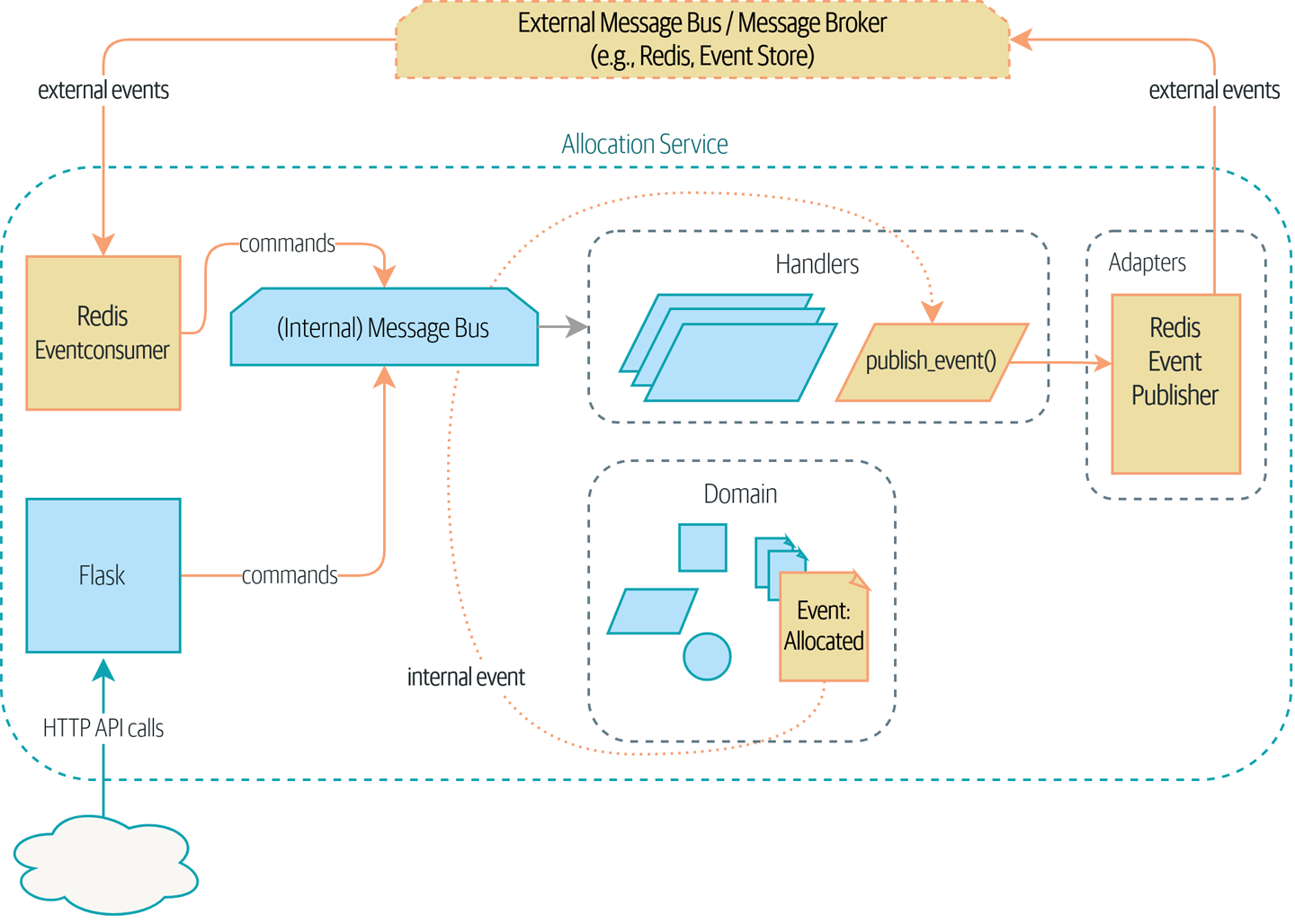

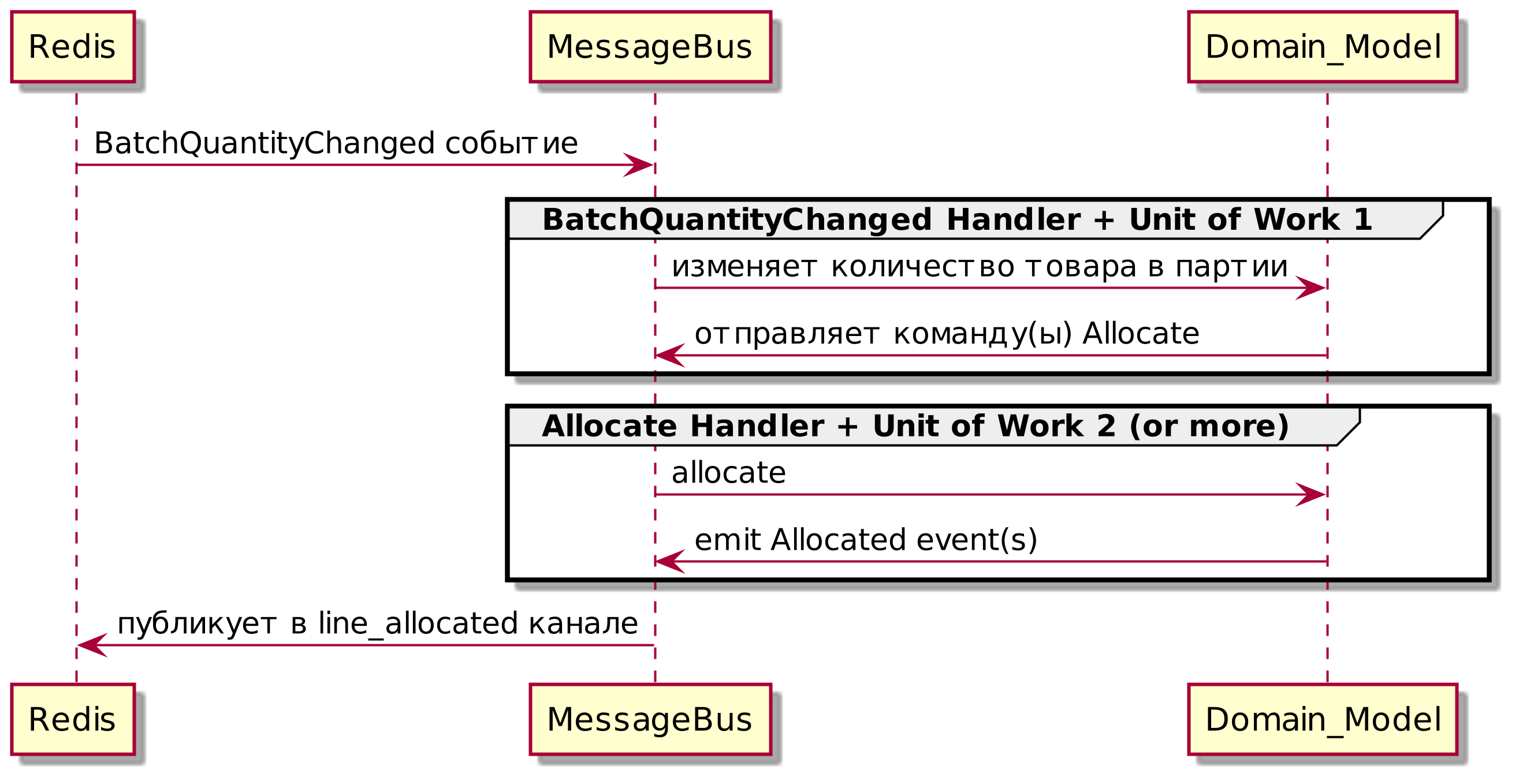

Мы вводим еще три взаимно усиливающих шаблона: Domain Events, Message Bus, и Handler patterns. События домена (Domain Events)-это средство передачи идеи о том, что некоторые взаимодействия с системой являются триггерами для других. Мы используем шину сообщений Message Bus, чтобы позволить действиям вызывать события и вызывать соответствующие handlers (обработчики). Мы переходим к обсуждению того, как события могут быть использованы в качестве шаблона для интеграции между службами в архитектуре микросервисов. Наконец, мы различаем команды и события. Наше приложение теперь по сути является системой обработки сообщений.

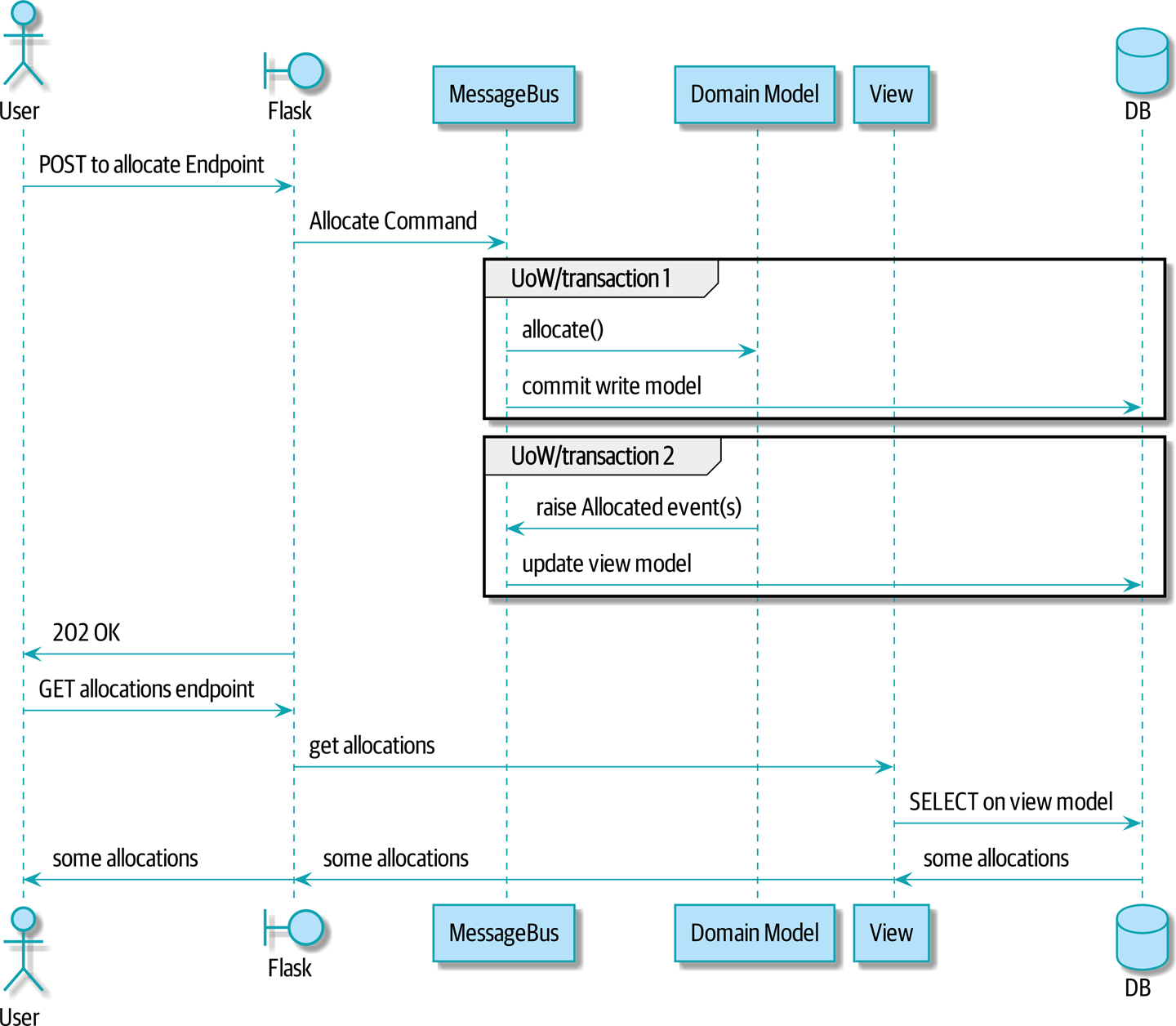

- Разделение ответственности по командам и запросам (Command-Query Responsibility Segregation (CQRS)[1])

-

Мы приводим пример разделения ответственности команд-запросов с событиями и без событий.

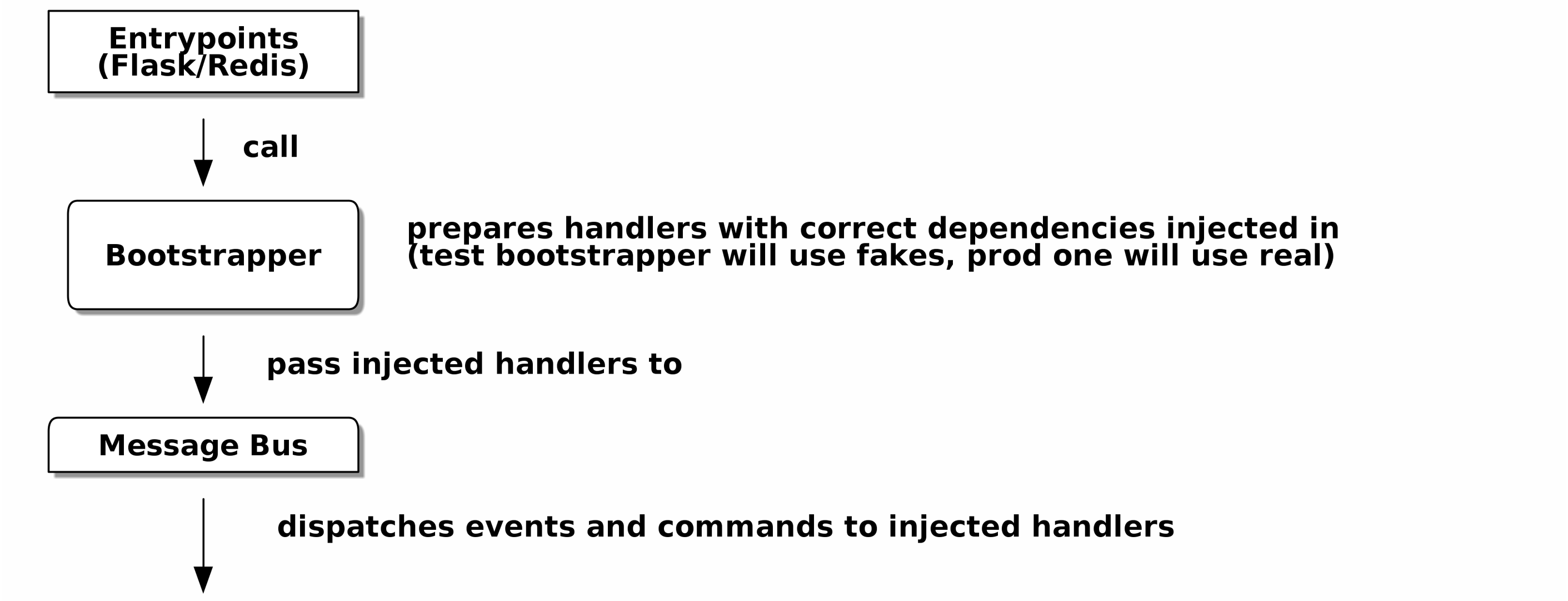

- Инъекция зависимостей (Dependency Injection (и Bootstrapping))

-

Мы приводим в порядок наши явные и неявные зависимости и реализуем простую структуру внедрения зависимостей.

Дополнительный контент

Как мне попасть туда отсюда?[3] (Эпилог):: Реализация архитектурных шаблонов всегда выглядит легко, когда вы показываете простой пример, начиная с нуля, но многие из вас, вероятно, зададутся вопросом, как применить эти принципы к существующему программному обеспечению. Мы дадим несколько указаний в эпилоге и некоторые ссылки для дальнейшего чтения.

Примеры кода и совместное кодирование

Постепенно читая эту книгу вы, вероятно, согласитесь с нами, когда мы скажем, что лучший способ узнать о коде — это код. Большую часть того, что мы знаем, мы узнали из общения с людьми, совместного написания кода с ними и обучения на практике, и мы хотели бы воссоздать этот опыт для вас как можно точнее в этой книге.

В результате мы построили книгу на примере одного проекта (хотя иногда мы приводим и другие примеры). Мы будем развивать этот проект по мере продвижения глав, как если бы вы были в паре с нами, и мы объясняем, что мы делаем и почему на каждом этапе.

Но чтобы по-настоящему разобраться с этими шаблонами, вам нужно повозиться с кодом и почувствовать, как он работает. Вы найдете весь код на GitHub; у каждой главы есть своя ветка. Вы также можете найти список веток на GitHub.

Вот три способа кодирования вместе с книгой:

-

Начните свой собственное репозиторий и попробуйте создать приложение, как это делаем мы, следуя примерам из листингов в книге и время от времени заглядывая в наше репо за подсказками. Однако предупреждаю: если вы читали предыдущую книгу Гарри и кодировали вместе с ней, вы обнаружите, что эта книга требует от вас проявить больше самостоятельности; вам, возможно, придется сильно полагаться на рабочие версии на GitHub.

-

Попробуйте применить каждый шаблон, главу за главой, к вашему собственному (желательно маленькому/игрушечному) проекту и посмотрите, сможете ли вы заставить его работать для вашего варианта использования. Высокий риск/высокая награда (и, кроме того, достаточные усилия!). Возможно придётся изрядно попотеть, чтобы заставить какие то вещи работать в соответствии со спецификой вашего проекта, но, с другой стороны, вероятно вы, узнаете много полезного.

-

В каждой главе мы описываем "Упражнение для читателя" и даём ссылки на GitHub, где вы можете скачать частично готовый код для главы с несколькими недостающими частями, чтобы написать его самостоятельно.

Особенно если вы намереваетесь применить некоторые из этих паттернов в своих собственных проектах, работа с простым примером-отличный способ безопасно практиковаться.

| По крайней мере, выполняйте «git checkout» кода из нашего репозитория при чтении каждой главы. Возможность сразу же увидеть код в контексте реального работающего приложения поможет ответить на множество вопросов по ходу дела и сделает все более реальным. Вы найдете инструкции, как это сделать, в начале каждой главы. |

Лицензия

Код (и онлайн-версия книги) находится под лицензией Creative Commons CC BY-NC-ND, что означает, что вы можете свободно копировать и делиться им с кем угодно в некоммерческих целях при условии указания авторства. Если вы хотите повторно использовать какой-либо контент из этой книги и у вас есть какие-либо опасения по поводу лицензии, свяжитесь с O’Reilly permissions@oreilly.com.

Печатное издание лицензируется по-другому; см. страницу об авторских правах.

Условные обозначения, используемые в этой книге

В этой книге используются следующие типографские условные обозначения:

- Курсив

-

Указывает новые термины, URL-адреса, адреса электронной почты, имена файлов и расширения файлов.

- Постоянная ширина

-

Используется для листинга программ, а также в абзацах для обозначения программных элементов, таких как имена переменных или функций, базы данных, типы данных, переменные среды, операторы и ключевые слова.

Постоянная ширина жирный шрифт-

Показывает команды или другой текст, который должен быть набран буквально пользователем.

- Курсив постоянной ширины

-

Показывает текст, который должен быть заменен пользовательскими значениями или значениями, определяемыми контекстом.

|

Этот элемент означает подсказку или предложение. |

|

Этот элемент обозначает общее примечание. |

|

Этот элемент указывает на предупреждение или предостережение. |

Онлайн-обучение O’Reilly

|

Более 40 лет O’Reilly Media предоставляет технологии и бизнес-тренинги, знания и идеи, чтобы помочь компаниям добиться успеха. |

Наша уникальная сеть экспертов и новаторов делится своими знаниями и опытом с помощью книг, статей, конференций и нашей онлайн-платформы обучения. Платформа онлайн-обучения O’Reilly предоставляет вам доступ по требованию к живым учебным курсам, углубленным учебным путям, интерактивным средам кодирования и обширной коллекции текстов и видео от O’Reilly и более чем 200 других издателей. Для получения дополнительной информации, пожалуйста, посетите сайт http://oreilly.com.

Как связаться с O’Reilly

Пожалуйста, направляйте комментарии и вопросы, касающиеся этой книги, издателю:

- O’Reilly Media, Inc.

- 1005 Gravenstein Highway North

- Sebastopol, CA 95472

- 800-998-9938 (in the United States or Canada)

- 707-829-0515 (international or local)

- 707-829-0104 (fax)

У нас есть веб-страница для этой книги, где мы перечисляем ошибки, примеры и любую дополнительную информацию. Вы можете получить доступ к этой странице по адресу https://oreil.ly/architecture-patterns-python.

Email bookquestions@oreilly.com для комментариев и технических вопросов по этой книге.

Для получения дополнительной информации о наших книгах, курсах, конференциях и новостях посетите наш веб-сайт по адресу http://www.oreilly.com.

Найдите нас на Facebook: http://facebook.com/oreilly

Следите за нами в Twitter: http://twitter.com/oreillymedia

Смотрите нас на YouTube: http://www.youtube.com/oreillymedia

Благодарности

Нашим техническим обозревателям Дэвиду Седдону, Эду Юнгу и Хайнеку Шлаваку: мы абсолютно не заслуживаем вас. Вы все невероятно преданные, добросовестные и строгие. Каждый из вас безмерно умен, и ваши разные точки зрения были полезны и дополняли друг друга. Спасибо вам от всего сердца.

Огромное спасибо всем нашим читателям за их комментарии и предложения: Йен Купер, Абдулла Арифф, Джонатан Мейер, Гил Гонсалвес, Матье Чоплин, Бен Джадсон, Джеймс Грегори, Лукаш Лехович, Клинтон Рой, Виторино Араужо, Сьюзан Гудбоди, Джош Харвуд, Дэниел Батлер, Лю Хайбин, Джимми Вергиа Игнасиа Игнас Канестрани, Ренне Роча, Педроаби, Ашиа Завадук, Йостейн Лейра, Брэндон Роудс, Язепс Баско, Симкимсия, Адриен Брюнет и многие другие; приносим свои извинения, если мы пропустили Вас в этом списке.

Супер-мега-спасибо нашему редактору Корбину Коллинзу за его нежное щебетание и за то, что он неутомимый защитник читателя. В такой же степени выражаем благодарность производственному персоналу Кэтрин Тозер, Шэрон Уилки, Эллен Траутман-Заиг и Ребекке Демарест за вашу преданность делу, профессионализм и внимание к деталям. Эта книга неизмеримо улучшена благодаря вам.

Любые ошибки, оставшиеся в книге, естественно, являются нашими собственными.

Введение

Почему Наш Дизайн Такой НЕУДАЧНЫЙ?

Что приходит на ум, когда вы слышите слово хаос? Возможно, вы думаете о шумной фондовой бирже или о своей кухне по утрам — все запутано и перемешано. Когда вы думаете о слове порядок, возможно, вы думаете о пустой комнате, безмятежной и спокойной. Однако для ученых хаос характеризуется однородностью (sameness), а порядок — сложностью (difference).

Например, ухоженный сад — это упорядоченная система. Садоводы определяют границы дорожками и забором, размечают клумбы или грядки. Со временем сад развивается, становясь все богаче и гуще; но без целенаправленных усилий сад разрастётся. Сорняки и травы будут заглушать другие растения, покрывая дорожки, пока в конце концов все их части не станут снова такими же — дикими и неуправляемыми.

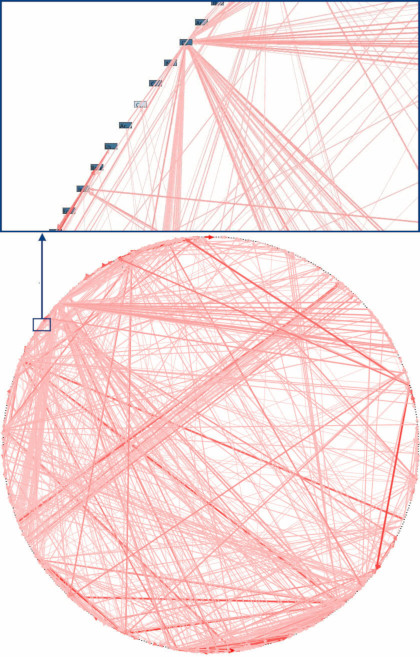

Программные системы тоже склонны к хаосу. Когда мы впервые начинаем строить новую систему, у нас есть грандиозные идеи, что наш код будет чистым и хорошо упорядоченным, но со временем мы обнаруживаем, что он включает ненужные и оборванные элементы кода и заканчивается запутанной трясиной менеджеров классов и утилитных модулей. Мы обнаруживаем, что наша разумная многослойная архитектура рухнула сама по себе, как какая то безделушка. Хаотические программные системы характеризуются одинаковостью функций: обработчики API, которые знают предметную область и отправляют электронную почту и выполняют регистрацию; классы «бизнес-логики», которые не выполняют вычислений, но выполняют ввод-вывод; и все вместе со всем остальным, так что изменение любой части системы чревато опасностью. Это настолько распространено, что у разработчиков программного обеспечения есть собственный термин для обозначения хаоса: антипаттерн "the Big Ball of Mud" (Большой шар грязи или нелитературно по русски говнокод :) ) (Схема зависимостей из реальной жизни (source: "Enterprise Dependency: Big Ball of Yarn" by Alex Papadimoulis)).

| Говнокод — естественное состояние программного обеспечения, так же как болезнь — естественное состояние вашего сада. Чтобы предотвратить коллапс, нужны энергия и направление. |

К счастью, методы, позволяющие избежать этого, не сложны.

Инкапсуляции и абстракции

Инкапсуляция и абстракция — это инструменты, к которым мы все как программисты инстинктивно стремимся, даже если не все используем именно эти слова. Позвольте нам ненадолго остановиться на них, поскольку они являются постоянной фоновой темой книги.

Термин инкапсуляция охватывает две тесно связанные идеи: упрощение поведения и скрытие данных. В этом обсуждении мы используем первое. Мы инкапсулируем поведение, определяя задачу, которую необходимо выполнить в нашем коде, и передаём эту задачу четко определенному объекту или функции. И называем этот объект или функцию абстракцией.

Взгляните на следующие два фрагмента кода Python:

import json

from urllib.request import urlopen

from urllib.parse import urlencode

params = dict(q='Sausages', format='json')

handle = urlopen('http://api.duckduckgo.com' + '?' + urlencode(params))

raw_text = handle.read().decode('utf8')

parsed = json.loads(raw_text)

results = parsed['RelatedTopics']

for r in results:

if 'Text' in r:

print(r['FirstURL'] + ' - ' + r['Text'])import requests

params = dict(q='Sausages', format='json')

parsed = requests.get('http://api.duckduckgo.com/', params=params).json()

results = parsed['RelatedTopics']

for r in results:

if 'Text' in r:

print(r['FirstURL'] + ' - ' + r['Text'])Оба кода делают одно и то же: они отправляют закодированные в форме значения на URL-адрес, чтобы использовать API поисковой системы. Но второе проще читать и понимать, потому что оно работает на более высоком уровне абстракции.

Мы можем сделать еще один шаг вперед, определив и назвав задачу, которую нам хотелось бы, чтобы код выполнял для нас, и используем еще более высокоуровневую абстракцию, чтобы сделать ее явной:

import duckduckpy

for r in duckduckpy.query('Sausages').related_topics:

print(r.first_url, ' - ', r.text)Инкапсуляция поведения с помощью абстракций-это мощный инструмент для того, чтобы сделать код более выразительным, более тестируемым и более простым в обслуживании.

| В литературе, посвященной объектно-ориентированному (ОО) миру, одна из классических характеристик этого подхода называется responsibility-driven design; в нем используются слова roles (роли) и responsibilities (обязанности), а не tasks (задачи). Главное — думать о коде с точки зрения поведения, а не с точки зрения данных или алгоритмов.[4] |

Большинство шаблонов в этой книге связаны с выбором абстракции, поэтому вы увидите множество примеров в каждой главе. Кроме того, Краткая интерлюдия: О Связях и Абстракции конкретно обсуждает некоторые общие эвристики для выбора абстракций.

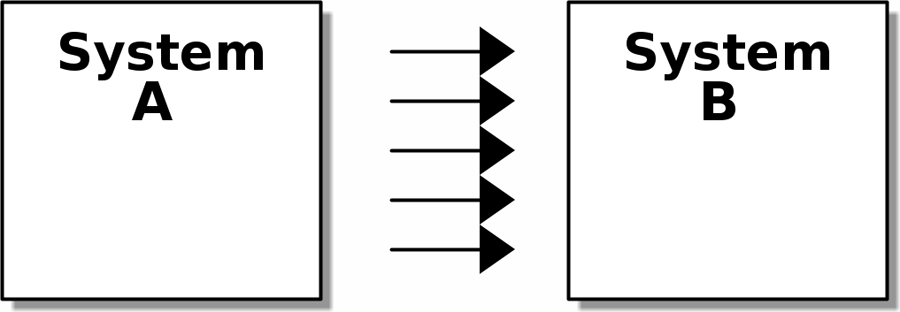

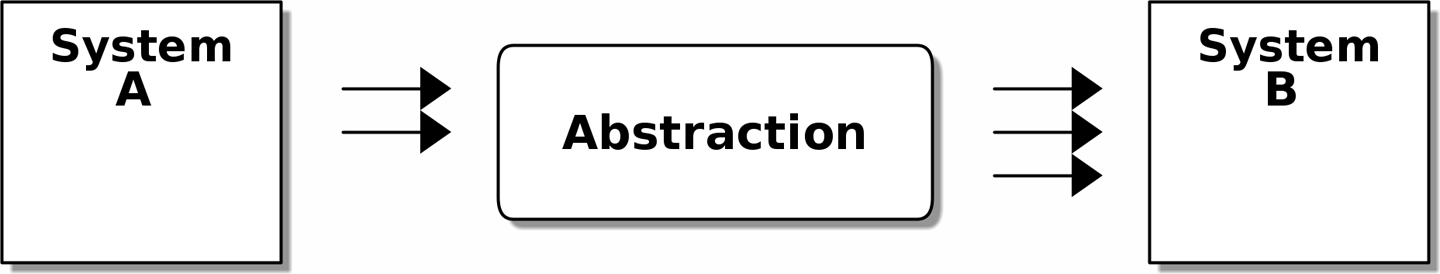

Многоуровневое представление

Инкапсуляция и абстракция помогают нам скрывать детали и защищать целостность наших данных, но нам также необходимо помнить о взаимодействии между нашими объектами и функциями. Когда одна функция, модуль или объект использует другую, мы говорим, что одна depends on (зависима) от другой. Эти зависимости образуют своего рода сеть или граф.

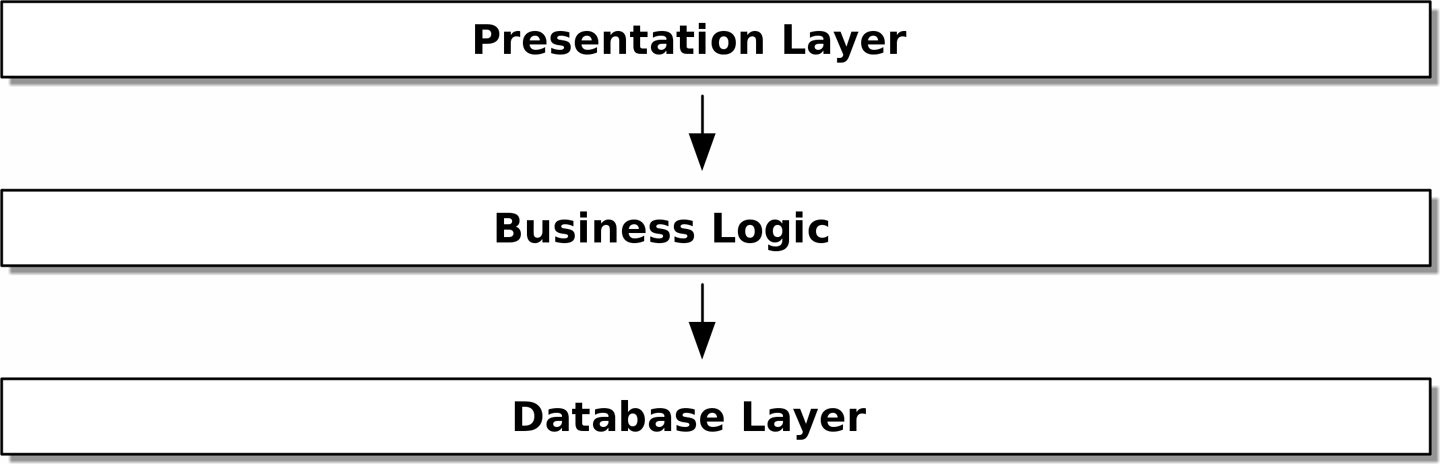

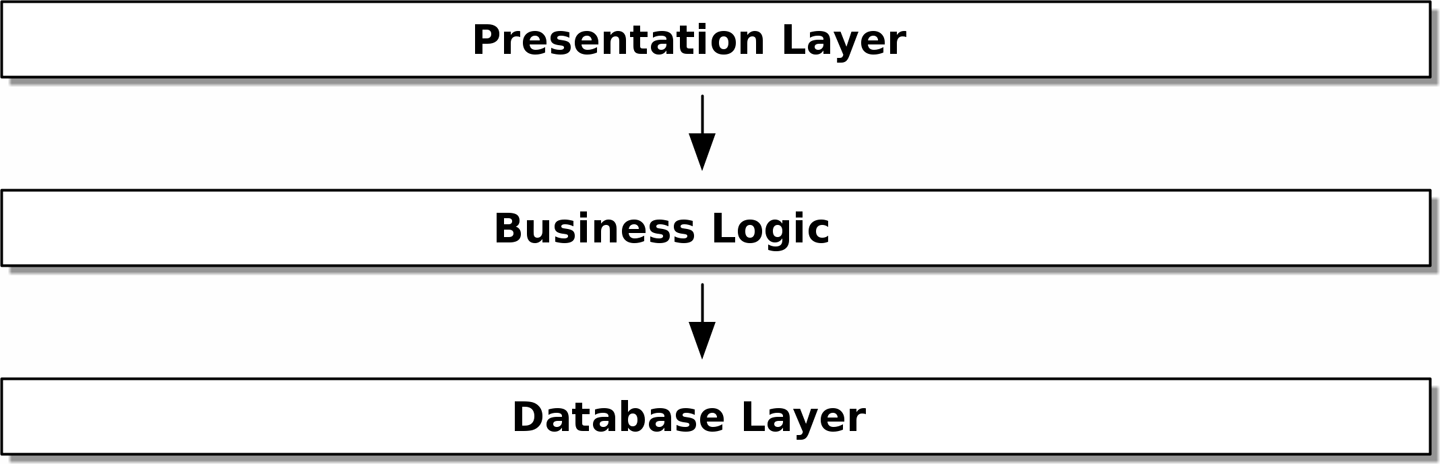

В большом комке грязи зависимости выходят из-под контроля (как вы видели в Схема зависимостей из реальной жизни (source: "Enterprise Dependency: Big Ball of Yarn" by Alex Papadimoulis)). Изменение одного узла графа становится затруднительным, поскольку оно может повлиять на многие другие части системы. Слоистые архитектуры являются одним из способов решения этой проблемы. В многоуровневой архитектуре мы разделяем наш код на отдельные категории или роли и вводим правила касающеся того, какие категории кода могут вызывать друг друга.

Одним из наиболее распространенных примеров является трехслойная архитектура, показанная на рис. Многоуровневая архитектура.

[ditaa, apwp_0002]

+----------------------------------------------------+

| Уровень представления |

+----------------------------------------------------+

|

V

+----------------------------------------------------+

| Бизнес-логика |

+----------------------------------------------------+

|

V

+----------------------------------------------------+

| Уровень базы данных |

+----------------------------------------------------+

Многоуровневая архитектура является, пожалуй, наиболее распространенным шаблоном для построения business software — коммерческого ПО. В этой модели у нас есть компоненты пользовательского интерфейса, которые могут быть веб-страницей, API или командной строкой; эти компоненты пользовательского интерфейса взаимодействуют со слоем бизнес-логики, который содержит наши бизнес-правила и наши рабочие процессы; и, наконец, у нас есть уровень базы данных, который отвечает за хранение и извлечение данных.

До конца этой книги мы будем систематически выворачивать эту модель наизнанку, следуя одному простому принципу.

The Dependency Inversion Principle (Принцип инверсии зависимостей)

Возможно, вы уже знакомы с принципом инверсии зависимостей (DIP), потому что это D в SOLID. [5]

К сожалению, мы не можем проиллюстрировать DIP, используя три небольших листинга кода, как мы это делали для инкапсуляции. Однако вся [Часть1] по сути представляет собой отработанный пример реализации DIP во всем приложении, так что вы получите множество конкретных примеров.

А пока можно поговорить о формальном определении DIP:

-

Модули высокого уровня не должны зависеть от модулей низкого уровня. И то и другое должно зависеть от абстракций.

-

Абстракции не должны зависеть от деталей. Вместо этого детали должны зависеть от абстракций.

Но что это значит? Давайте разберемся по крупицам.

Модули высокого уровня это код, который действительно волнует вашу организацию. Возможно, вы работаете в фармацевтической компании, и ваши высокоуровневые модули имеют дело с пациентами и испытаниями. Возможно, вы работаете в банке, и ваши высокоуровневые модули управляют сделками и биржами. Высокоуровневые модули программной системы-это функции, классы и пакеты, которые имеют дело с нашими концепциями реального мира.

Напротив, низкоуровневые модули — это код, который вашей организации не важен. Маловероятно, что ваш отдел кадров будет в восторге от файловых систем или сетевых сокетов. Нечасто вы обсуждаете SMTP, HTTP или AMQP со своим финансовым отделом. Для наших нетехнических заинтересованных сторон эти низкоуровневые концепции не интересны и не актуальны. Все, что их волнует, — это правильность работы высокоуровневых концепций. Если расчет заработной платы выполняется вовремя, вашему бизнесу вряд ли будет важно, выполняется ли это задание cron или временная функция, выполняемая в Kubernetes.

Depends on (зависит от) не обязательно означает imports или calls, а скорее несёт более общую идею о том, что один модуль knows about (знает о) или needs (нуждается в) другом модуле.

И мы уже упоминали abstractions: это упрощенные интерфейсы, которые инкапсулируют поведение, подобно тому, как наш модуль duckduckgo инкапсулирует API поисковой системы.

Все проблемы в информатике можно решить, добавив еще один косвеный уровень.

Итак, первая часть DIP говорит, что наш бизнес и код не должны зависеть от технических деталей; вместо этого оба должны использовать абстракции.

Почему? Говоря по простому: мы хотим иметь возможность изменять их независимо друг от друга. Модули высокого уровня должны быть легко изменены в соответствии с потребностями бизнеса. Низкоуровневые модули (детали) часто на практике сложнее изменить: подумайте о рефакторинге для изменения имени функции по сравнению с определением, тестированием и развертыванием миграции базы данных для изменения имени столбца. Мы не хотим, чтобы изменения бизнес-логики замедлялись, потому что они тесно связаны с деталями инфраструктуры низкого уровня. Но точно так же важно иметь возможность изменять детали инфраструктуры, когда это необходимо (например, подумайте о сегментировании базы данных), без необходимости вносить изменения в бизнес-уровень. Добавление абстракции между ними (знаменитый дополнительный слой косвенности) позволяет им изменяться (более) независимо друг от друга.

Вторая часть еще более загадочна. «Абстракции не должны зависеть от деталей» кажется достаточно ясным, но «Детали должны зависеть от абстракций» трудно себе представить. Как мы можем получить абстракцию, которая не зависит от деталей, которые она абстрагирует? К тому времени, когда мы дойдем до Наш первый Use Case или пример использования: Flask API и Service Layer, у нас будет конкретный пример, который должен прояснить все это.

Место для Всей Нашей Бизнес-логики: Модель Предметной Области (The Domain Model)

Но прежде чем мы сможем вывернуть нашу трехуровневую архитектуру наизнанку, нам нужно больше поговорить об этом среднем слое: высокоуровневых модулях или бизнес-логике. Одна из наиболее распространенных причин, по которой наши проекты идут "как-то не так", заключается в том, что бизнес-логика распространяется по всем слоям нашего приложения, что затрудняет ее идентификацию, понимание и изменение.

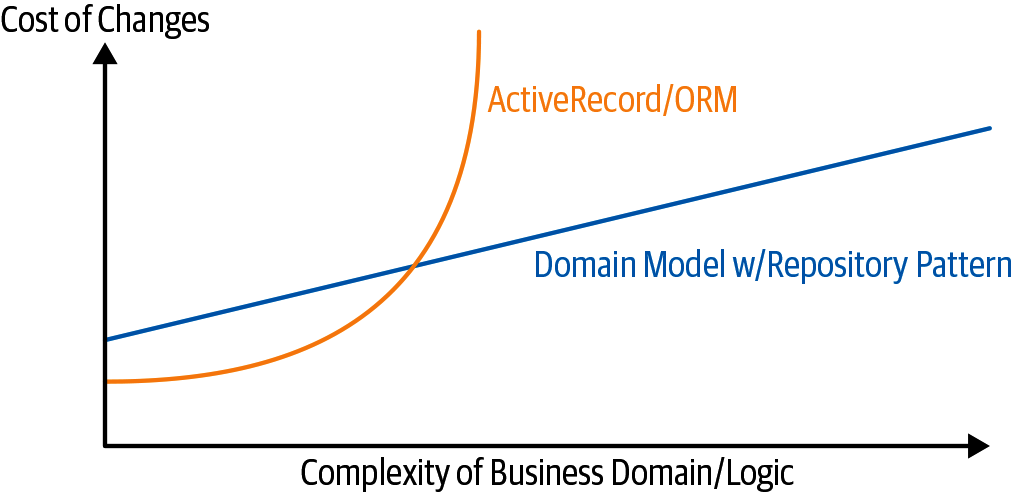

Domain Modeling показывает, как построить бизнес-уровень с помощью шаблона Domain Model. Остальные шаблоны в Построение архитектуры на основе поддержки модели предметной области показывают, как мы можем сохранить модель предметной области легко изменяемой и свободной от низкоуровневых проблем, выбирая правильные абстракции и постоянно применяя DIP.

1. Построение архитектуры на основе поддержки модели предметной области

Большинство разработчиков никогда не видели модель предметной области (domain model), только модель данных(data model).

DDD EU 2017

Большинство разработчиков, с которыми мы говорим об архитектуре, испытывают мучительное предчувствие, что все можно сделать лучше. И часто пытаясь спасти систему, которая каким-то образом вышла из строя, пытаются ввернуть какую-то структуру в "комок грязи". Они знают, что их бизнес-логика не должна распространяться повсюду, но они не знают, как это исправить.

Мы обнаружили, что многие разработчики, когда их просят спроектировать новую систему, немедленно приступают к построению схемы базы данных, а объектная модель рассматривается как нечто запоздалое. Вот тут-то все и начинает идти наперекосяк. Вместо этого поведение должно стоять на первом месте и определять наши требования к хранилищу. В конце концов, наших клиентов не волнует модель данных. Их волнует, что делает система.; в противном случае они просто использовали бы электронную таблицу.

Первая часть книги посвящена тому, как построить богатую объектную модель с помощью TDD (в Domain Modeling), а затем рассмотрим, как уберечь эту модель от технических проблем. Покажем, как создавать код, игнорирующий персистентность, и как создавать стабильные API-интерфейсы вокруг нашего домена, чтобы мы могли проводить агрессивный рефакторинг.

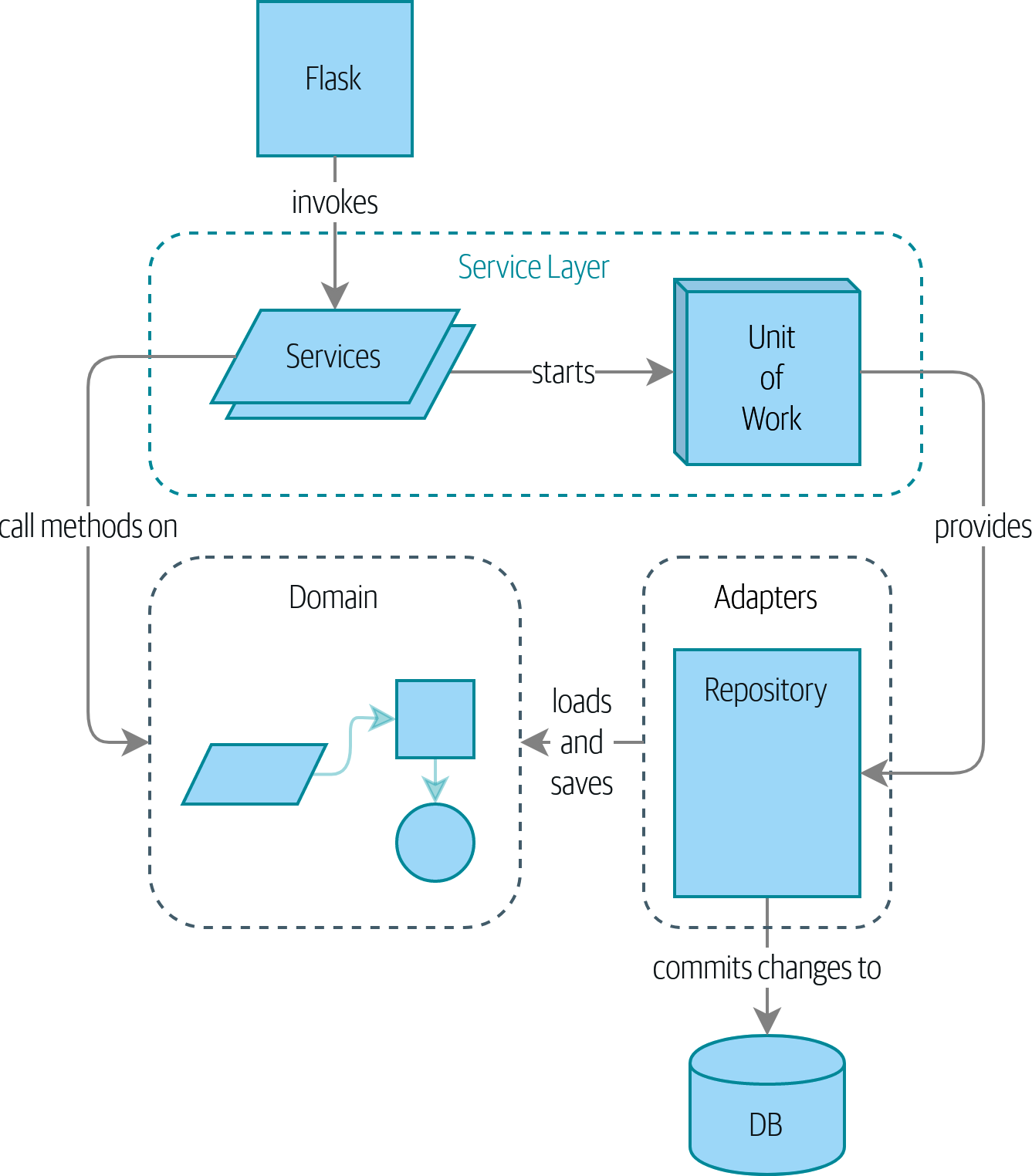

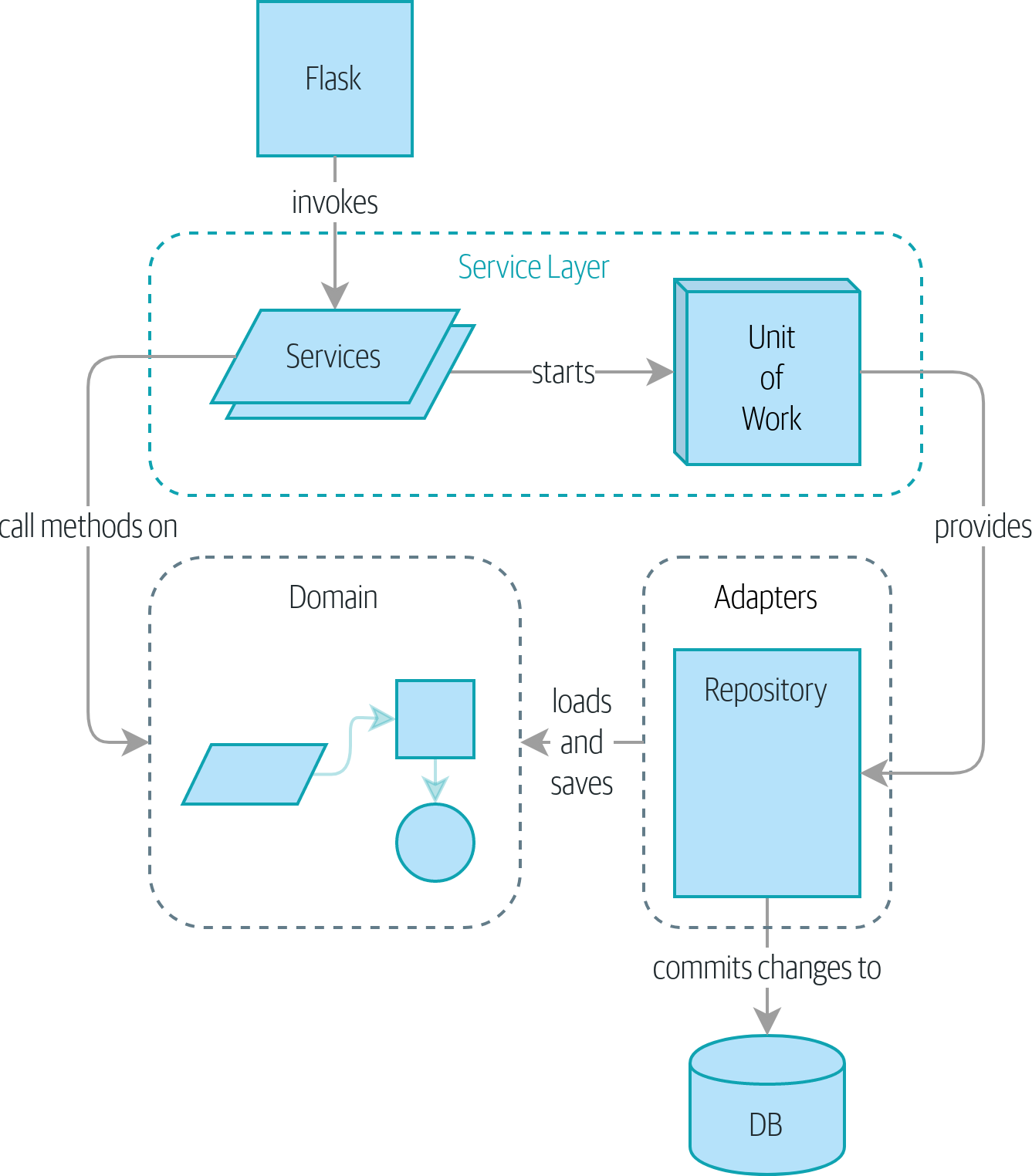

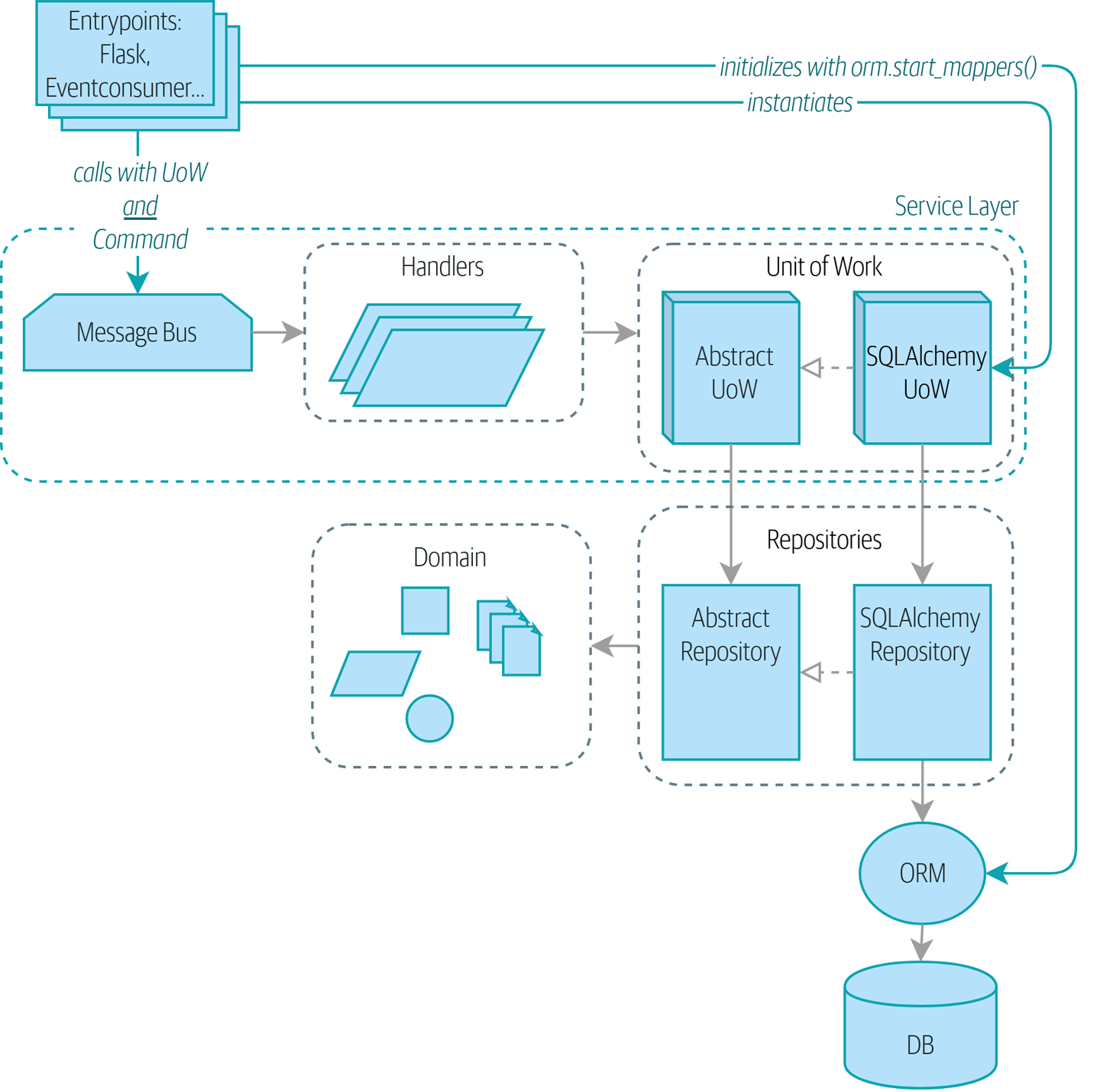

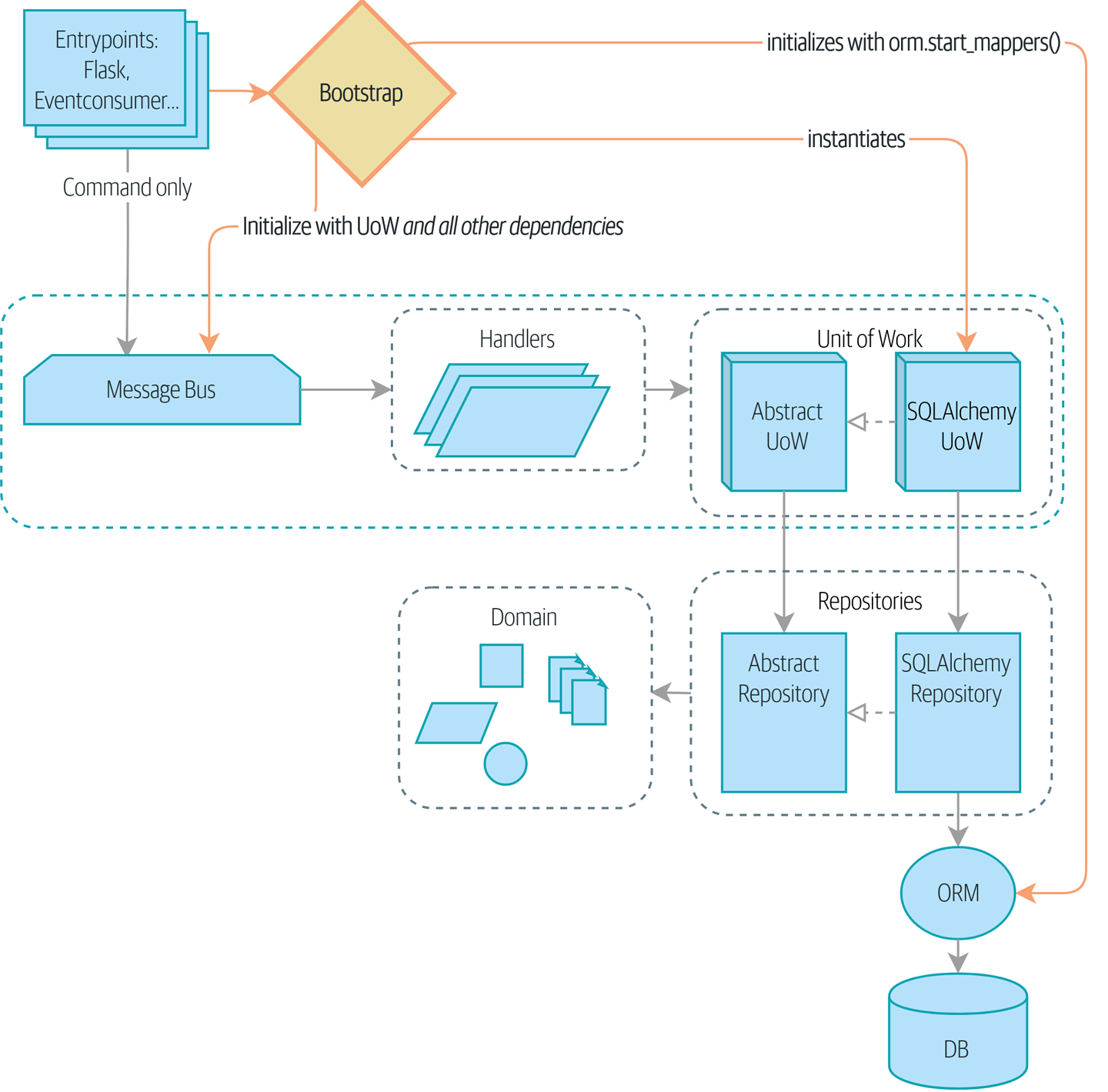

Для этого мы представляем четыре ключевых шаблона проектирования:

-

Repository pattern, абстракция над идеей постоянного хранения

-

Шаблон Service Layer четко определяет, где начинаются и заканчиваются наши варианты использования

-

Unit of Work pattern для обеспечения атомарных операций

-

Aggregate pattern для обеспечения целостности наших данных

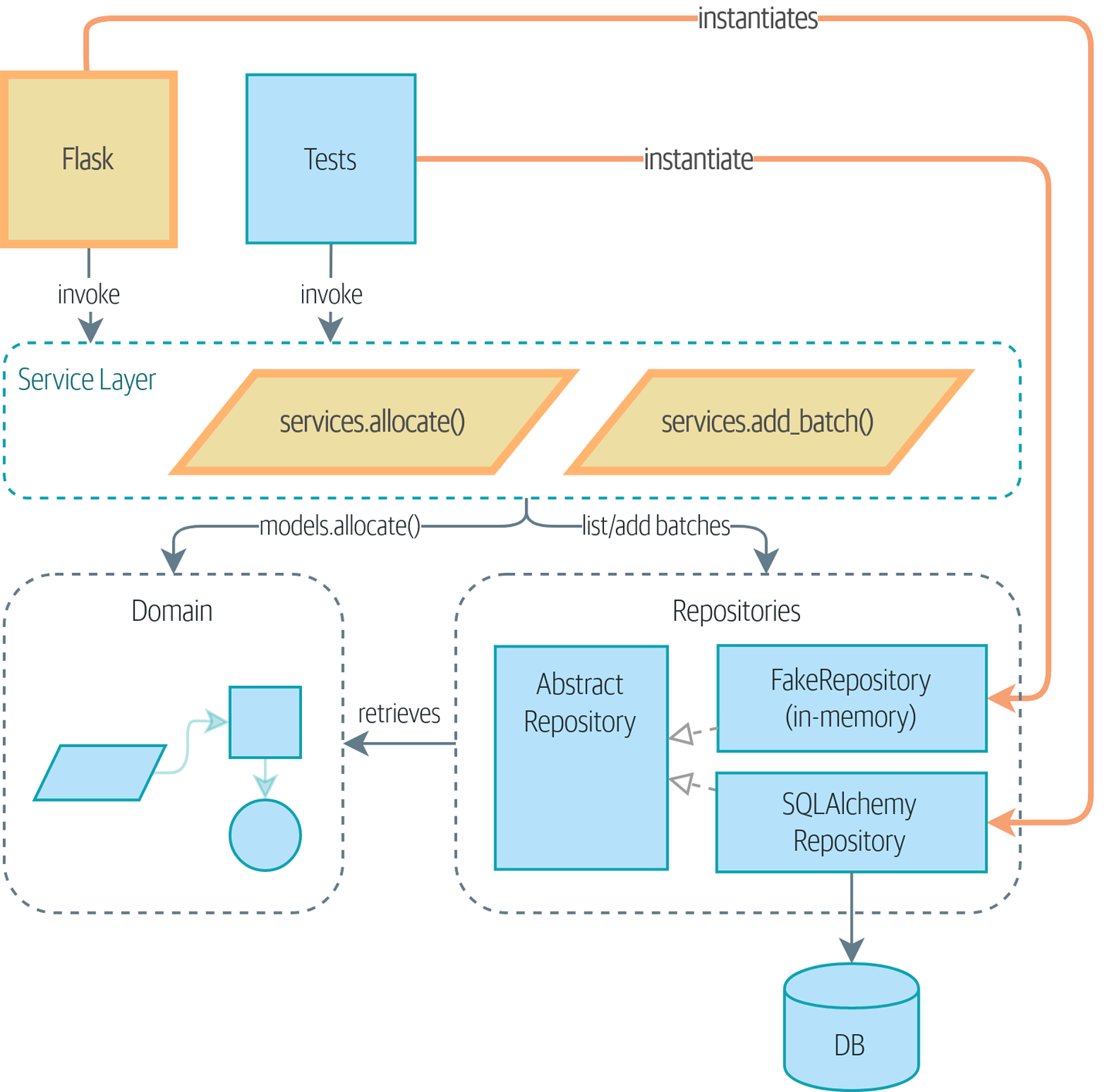

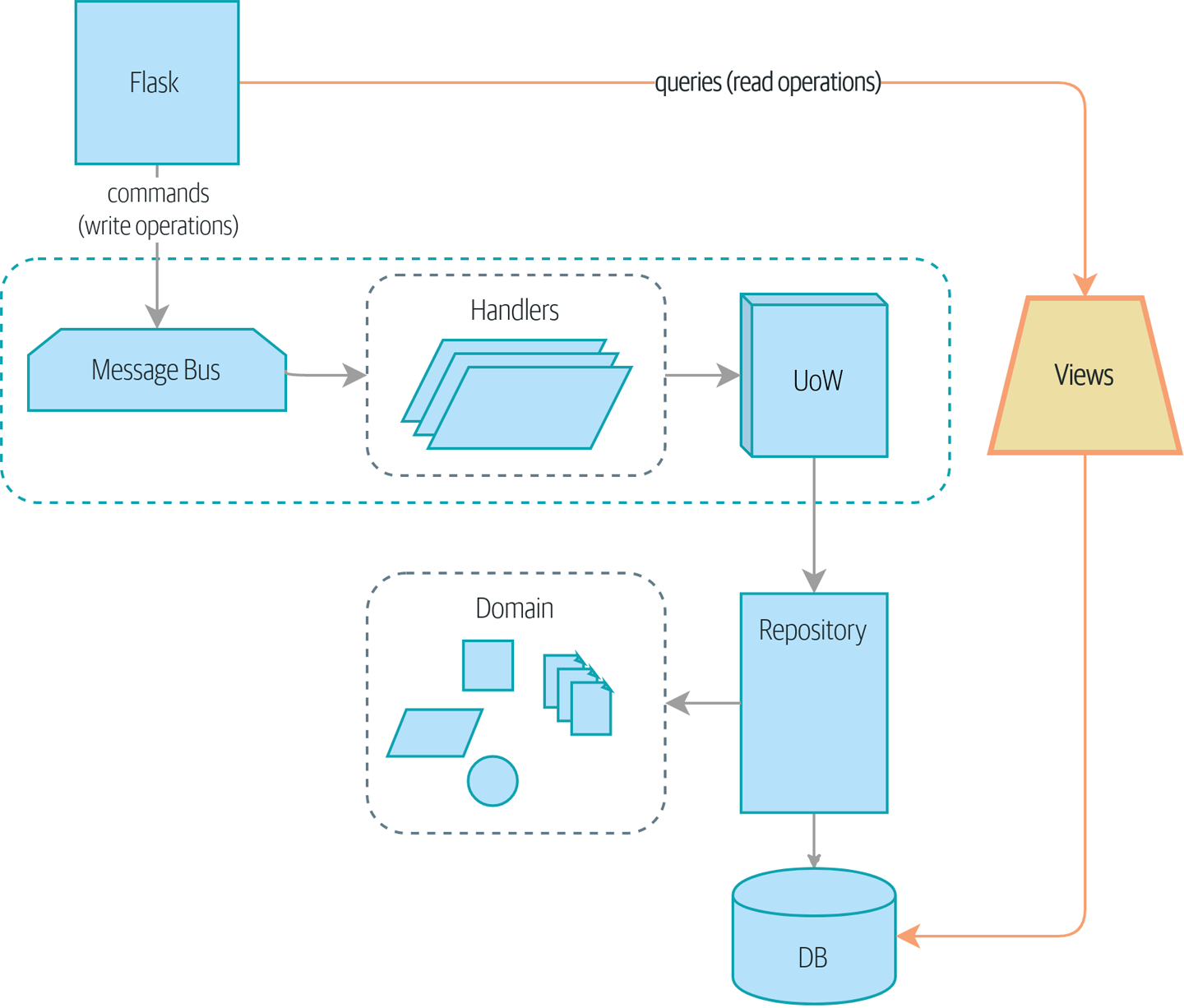

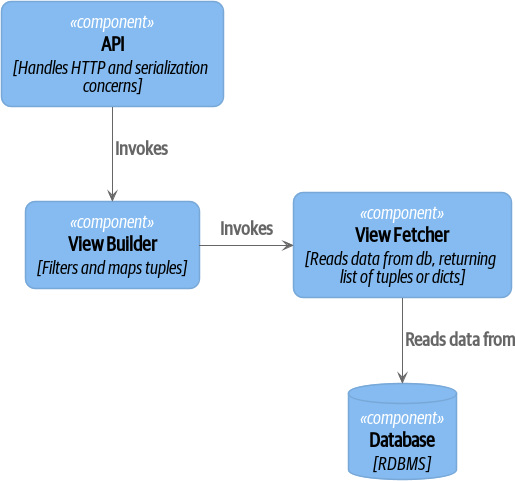

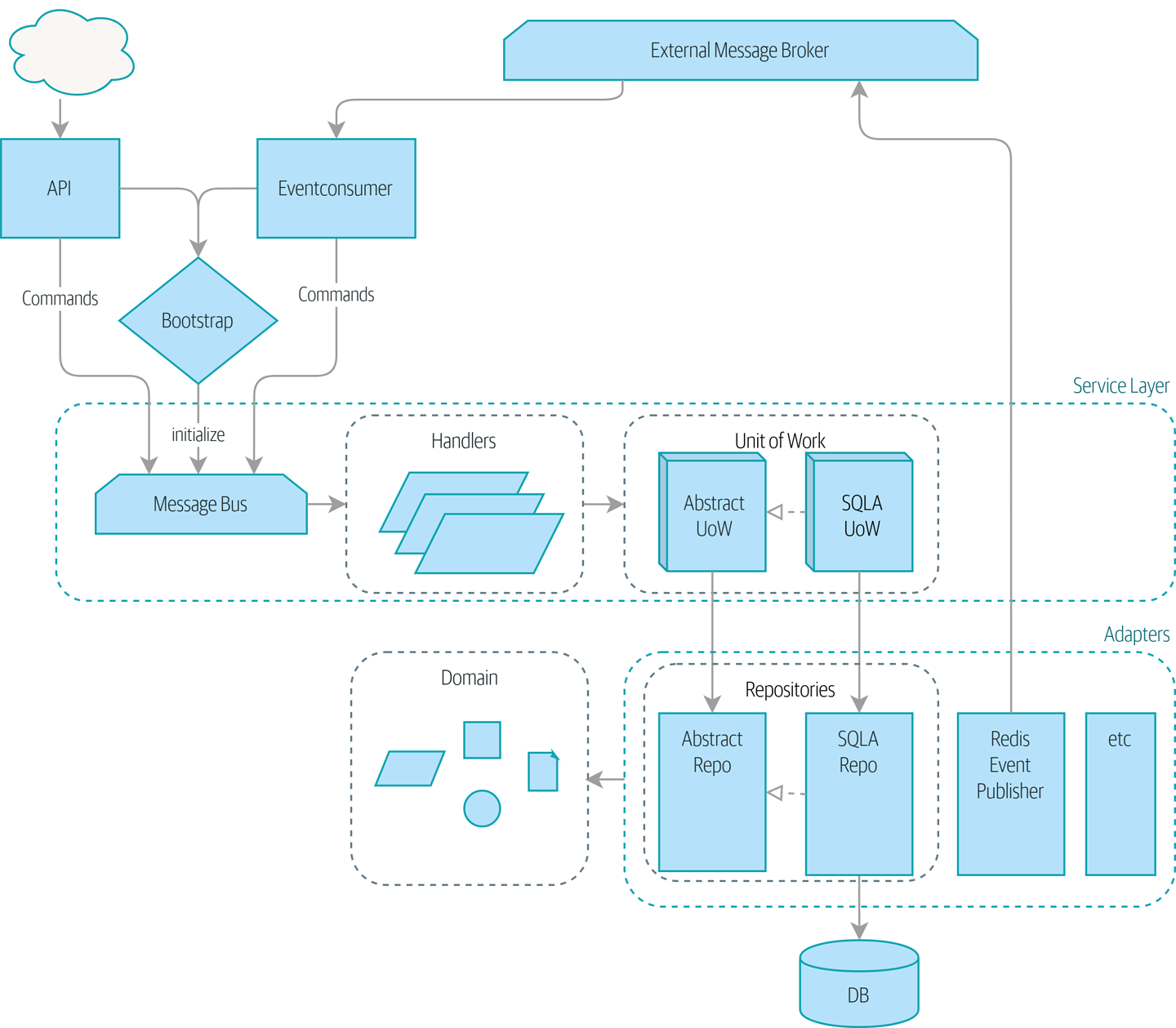

Если вам нужна картина того, куда мы в итоге придем, взгляните на Диаграмма компонентов для нашего приложения в конце Построение архитектуры на основе поддержки модели предметной области, но не волнуйтесь, если для вас все эта графика не имеет смысла! Мы разберём каждую фигуру изображенную на рисунке, одну за другой, на протяжении всей этой части книги.

Мы также уделим немного времени, чтобы поговорить о coupling and abstractions, проиллюстрировав это на простом примере, который показывает, как и почему мы выбираем наши абстракции.

Три приложения являются дальнейшими целями исследованиями содержания Части I:

-

Шаблонная структура проекта это описание инфраструктуры для нашего примера кода: как мы строим и запускаем образы Docker, где мы управляем информацией о конфигурации и как мы запускаем различные типы тестов.

-

Замена инфраструктуры: Делайте все с CSV это своего рода контент типа "proof is in the pudding", показывающий, как легко поменять всю нашу инфраструктуру—API Flask, ORM и Postgres-на совершенно другую модель ввода-вывода, включающую CLI и CSV.

-

Наконец, [appendix_django] может представлять интерес, если вам интересно, как эти паттерны могут выглядеть при использовании Django вместо Flask и SQLAlchemy.

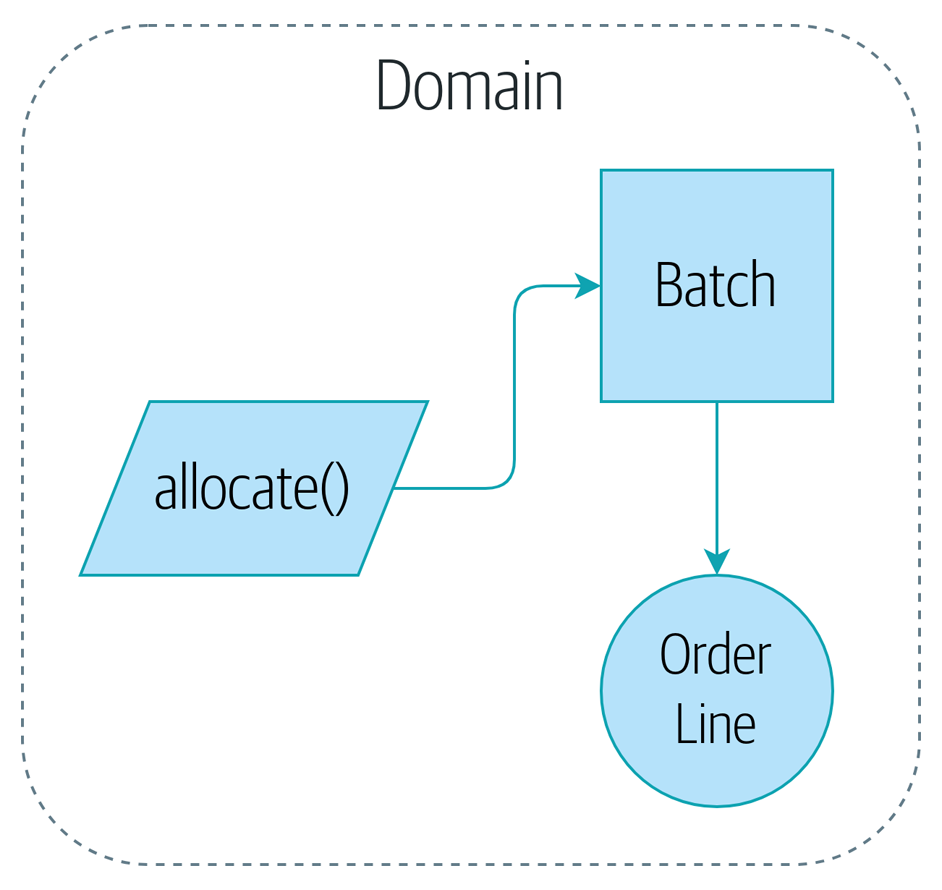

2. Domain Modeling

В этой главе рассматривается, как можно моделировать бизнес-процессы с помощью кода таким образом, чтобы он был полностью совместим с TDD (Test Driven Development). Обсудим, почему моделирование домена имеет важное значение, и рассмотрим несколько ключевых шаблонов для моделирования доменов: Entity, Value Object, и Domain Service.

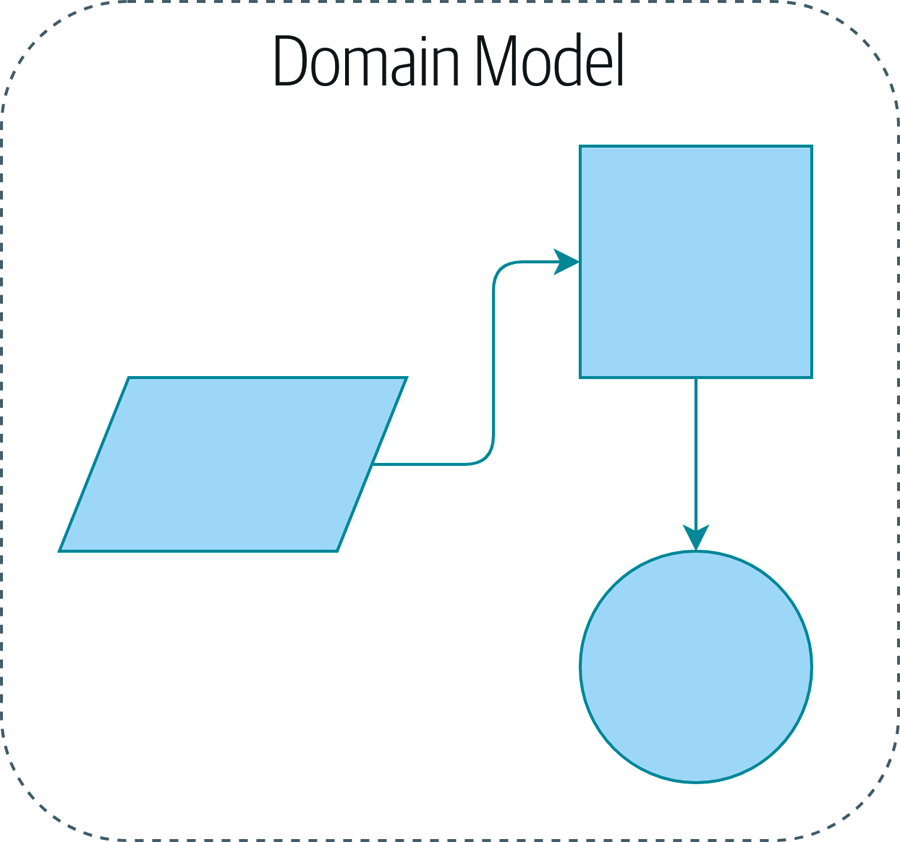

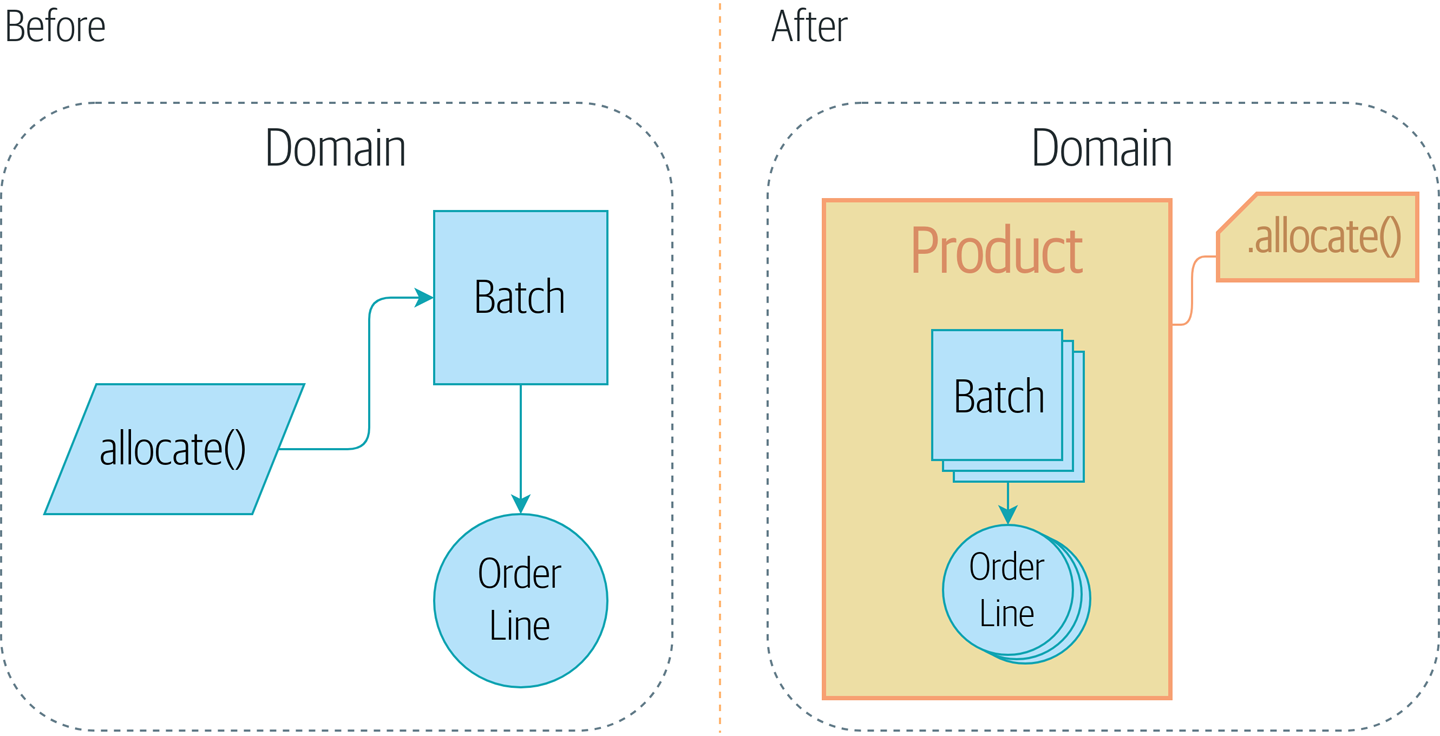

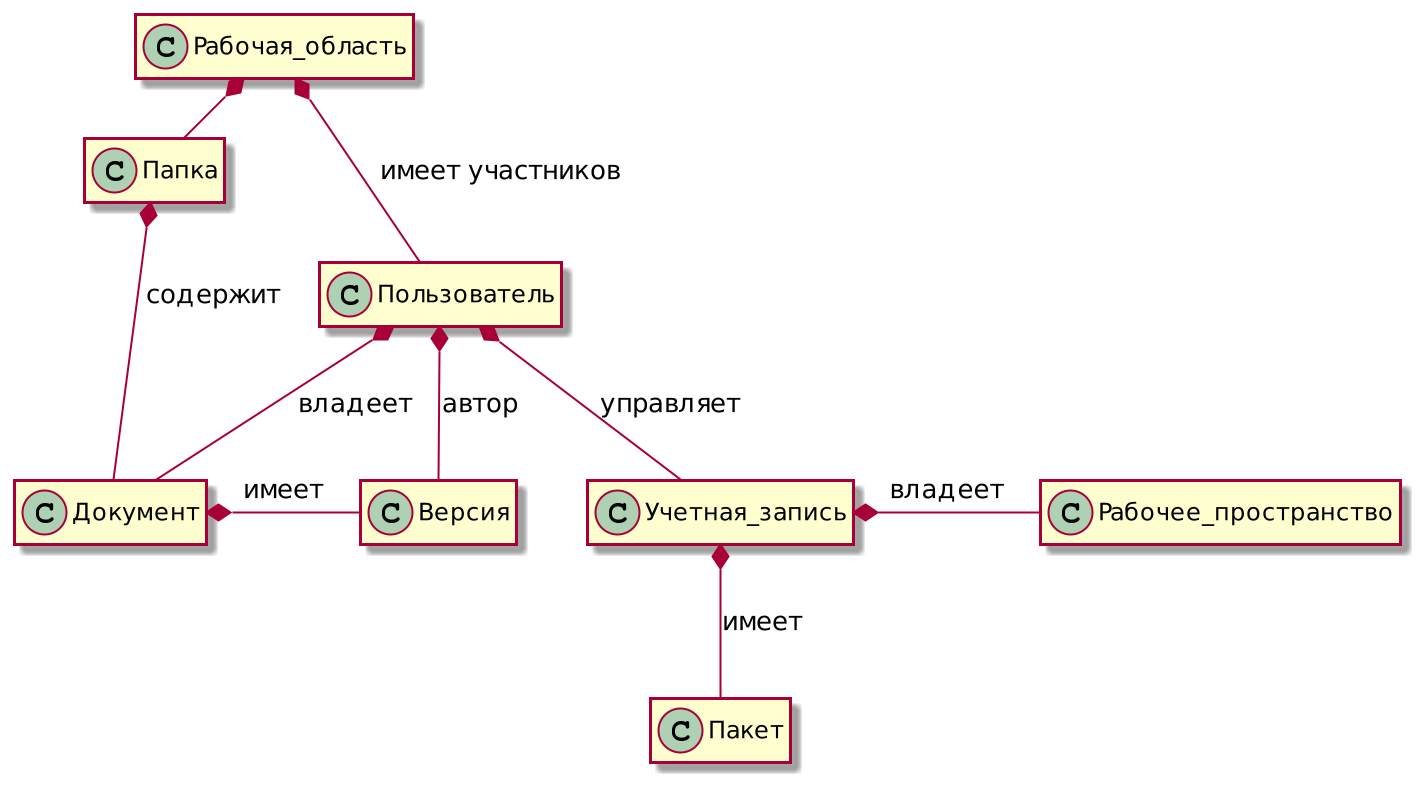

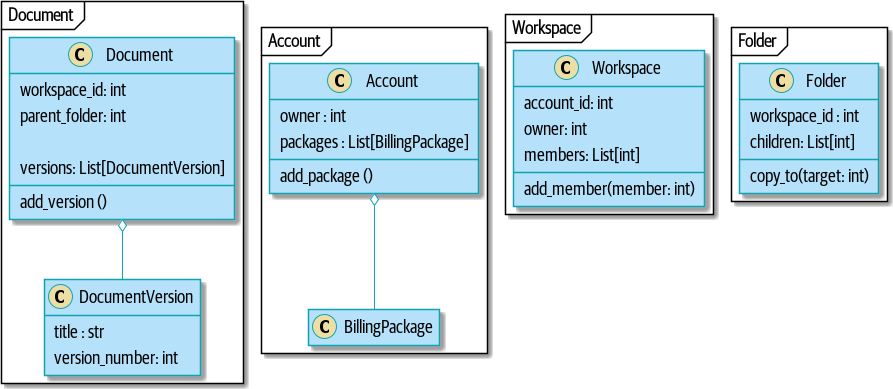

Иллюстрация прототипа нашей модели предметной области (Domain Model) это простое визуальное представление для нашего шаблона Domain Model. В этой главе мы расскажем о некоторых деталях, а когда перейдем к другим главам, то построим все вокруг Domain Model, но вы всегда должны быть в состоянии найти эти маленькие формы в центре.

2.1. Что такое Domain Model?

В introduction мы использовали термин business logic layer для описания центрального слоя трехслойной архитектуры. Для остальной части книги будем использовать термин domain model. Это термин из методологии Domain Driven Design (DDD), который лучше улавливает наш предполагаемый смысл (подробнее о DDD читайте дальше).

domain — причудливый способ обозначить проблему, которую вы пытаетесь решить. В настоящее время ваши авторы работают в мебельном интернет-магазине. В зависимости от того, о какой системе вы говорите, предметной областью может быть совершение разовых покупок и закупка по долгосрочным договорам, дизайн продукта или логистика и доставка. Большинство программистов проводят свои дни в попытках улучшить или автоматизировать бизнес-процессы; домен является набором действий, которые поддерживают эти процессы.

model — карта процесса или явления, которая фиксирует полезное свойство. Люди исключительно хороши в производстве моделей вещей в их головах. Например, когда кто-то бросает в вас мяч, вы можете предсказать его движение почти бессознательно, потому что у вас есть модель движения объектов в пространстве. Ваша модель ни в коем случае не идеальна. У людей есть ужасные интуитивные представления о том, как объекты ведут себя на околосветовых скоростях или в вакууме, потому что наша модель никогда не предназначалась для этих случаев. Это не означает, что модель неверна, но это означает, что некоторые прогнозы выходят за рамки её области.

Модель предметной области — это ментальная карта, которую владельцы бизнеса вешают у себя на стене в кабинете и которая отображает их мысли о структуре их бизнеса. У всех деловых людей есть эти ментальные карты — это изображене мыслей этих людей о сложных процессах.

Вы можете сразу определить, когда они ориентируются по этим картам, потому что они используют деловой язык. Жаргон возникает естественным образом среди людей, которые сотрудничают в сложных системах.

Представьте себе, что вы, наш несчастный читатель, внезапно перенеслись за много световых лет от Земли на борту инопланетного космического корабля со своими друзьями и семьей и должны выяснить, исходя из первых принципов, как вернуться домой.

В первые несколько дней вы наверное будете просто нажимать кнопки случайным образом, но вскоре разберётесь, какие кнопки что делают и сможете давать друг другу инструкции. "Нажми красную кнопку возле мигающей штуковины, а затем пребрось этот большой рычаг рядом с радарной хреновиной", — скажете вы.

Через пару недель вы станете более точными, определив слова для описания функций корабля: "Увеличить уровень кислорода в третьем грузовом отсеке" или "включите дополнительные двигатели." Через несколько месяцев вы бы придумали язык для целых сложных процессов: "Начать программу посадки " или "приготовиться к перегрузке." Этот процесс происходил бы совершенно естественно, без каких-либо формальных усилий по созданию общего глоссария.

Так и в обычном мире бизнеса. Терминология, используемая заинтересованными сторонами бизнеса, представляет собой дистиллированное понимание модели предметной области, где сложные идеи и процессы сводятся к одному слову или фразе.

Когда мы слышим, как наши деловые партнеры используют незнакомые слова или используют термины определенным образом, мы должны слушать, чтобы понять более глубокий смысл и закодировать их с трудом завоеванный опыт в наше программное обеспечение.

В этой книге мы будем использовать модель предметной области реального мира, в частности модель из нашей текущей работы. MADE.com является успешным мебельным ритейлером. Мы поставляем нашу мебель от производителей по всему миру и продаем её по всей Европе.

Когда вы покупаете диван или журнальный столик, мы должны решить, как лучше всего доставить ваш товар из Польши, Китая или Вьетнама в вашу гостиную.

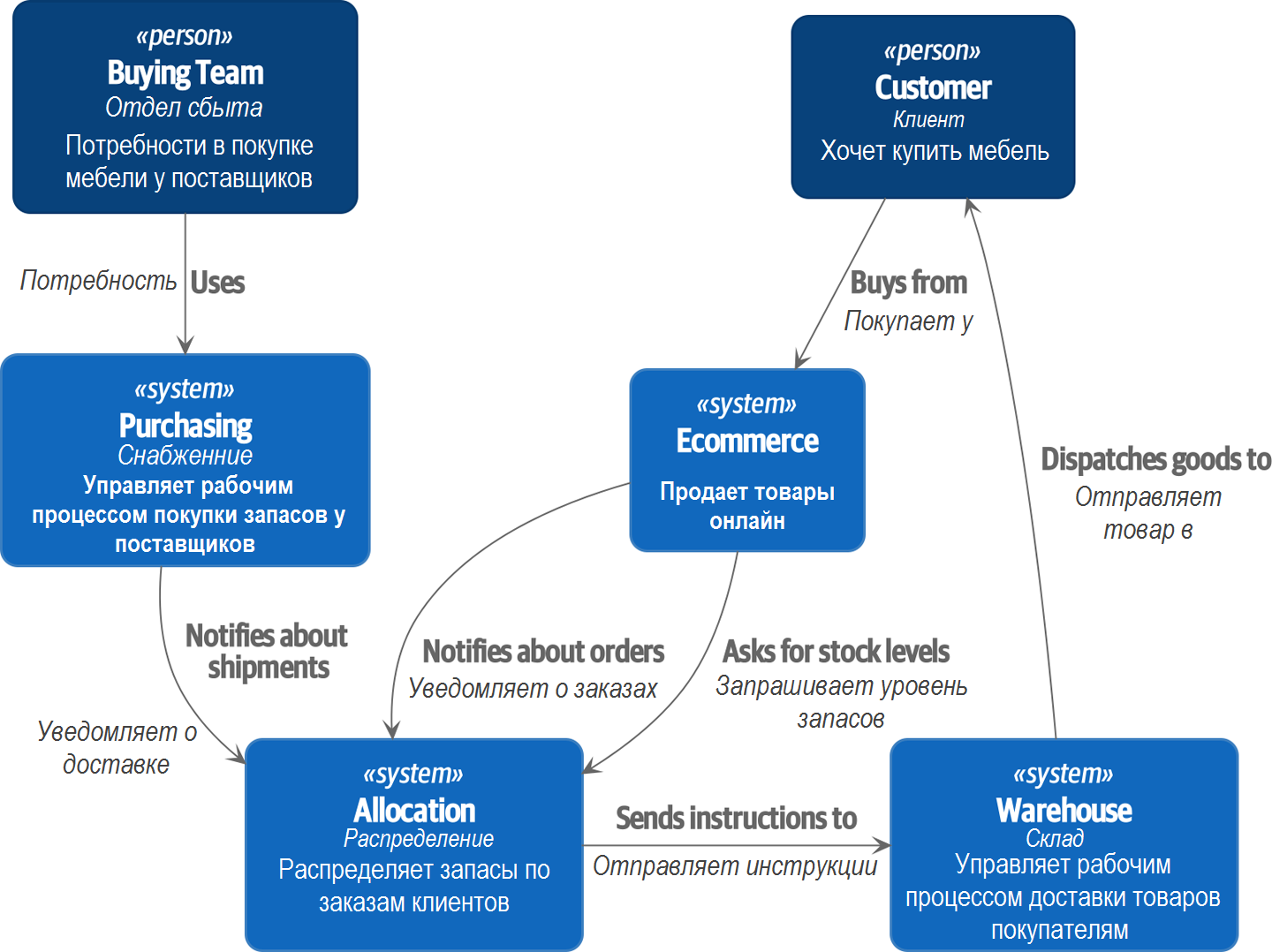

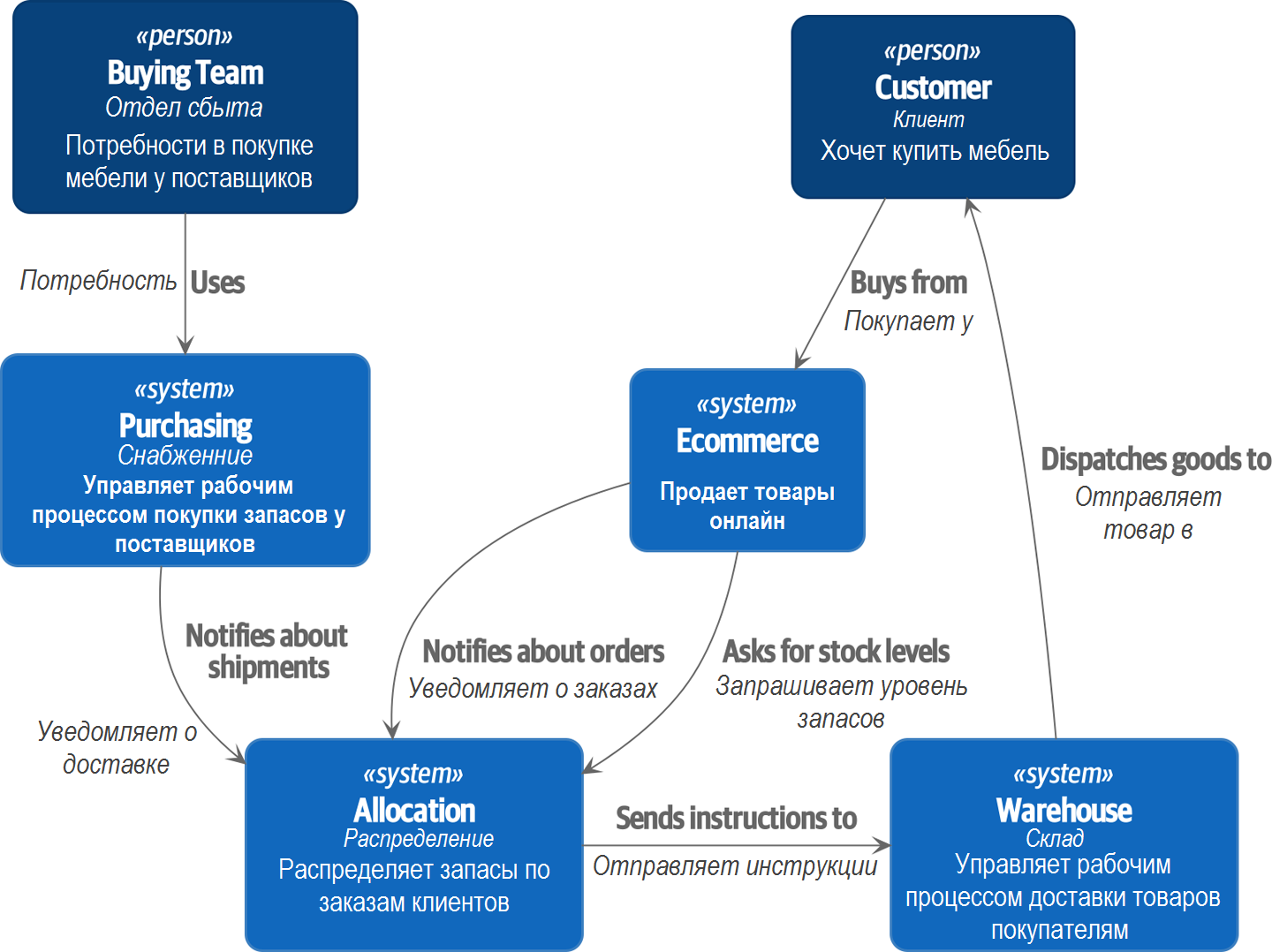

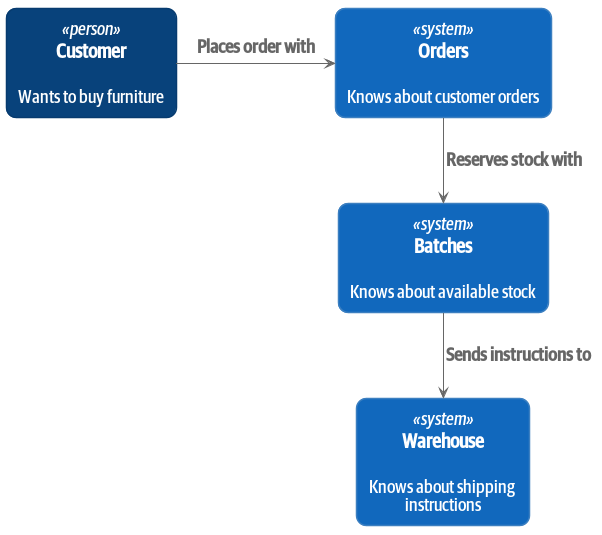

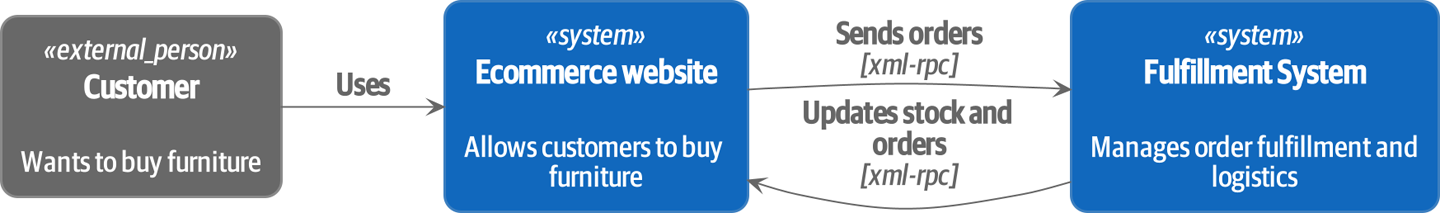

На высоком уровне у нас есть отдельные системы, которые отвечают за покупку акций, продажу акций клиентам и доставку товаров клиентам. Система в середине должна координировать процесс, распределяя запасы по заказам клиента; см. Контекстная диаграмма для службы распределения.

[plantuml, apwp_0102] @startuml Allocation Context Diagram !include https://raw.githubusercontent.com/plantuml-stdlib/C4-PlantUML/master/C4_Container.puml scale 2 System(systema, "Allocation", "Распределяет запасы по заказам клиентов") Person(customer, "Customer", "Хочет купить мебель") Person(buyer, "Buying Team", "Формирует заявку на закупку мебели у поставщиков") System(procurement, "Совершает закупку") , "Управляет рабочим процессом покупки запасов у поставщиков") System(ecom, "Ecommerce", "Продает товары онлайн") System(warehouse, "Warehouse", "Управляет рабочим процессом доставки товаров покупателям") Rel(buyer, procurement, "Использует") Rel(procurement, systema, "Notifies about shipments (Уведомляет о доставке)") Rel(customer, ecom, "Buys from (Покупает у)") Rel(ecom, systema, "Asks for stock levels (Запрашивает уровень запасов)") Rel(ecom, systema, "Notifies about orders (Уведомляет о заказах)") Rel_R(systema, warehouse, "Sends instructions to (Отправляет инструкции)") Rel_U(warehouse, customer, "Dispatches goods to (Отправляет товар в)") @enduml

В рамках этой книги, пофантазируем, что фирма решает внедрить новый способ распределения запасов. До сих пор компания представляла товар и время выполнения заказа на основе того, что физически доступно на складе. Если и вдруг склад пустеет, продукт считается "отсутствующим на складе" до тех пор, пока не поступит следующая партия от производителя.

Новая идея такова: если у нас есть система, которая может отслеживать все наши поставки и когда они должны прибыть, мы можем рассматривать товары на этих кораблях как реальные запасы и часть нашего инвентаря, просто с немного более длительным временем выполнения заказа. Не смотря на небольшие складские запасы, продавать будем больше, а бизнес сможет сэкономить деньги, уменьшив запасы на внутреннем складе.

Но распределение заказов больше не является тривиальным вопросом уменьшения одного количества в складской системе. Нам нужен более сложный механизм распределения. Время для некоторого моделирования предметной области.

2.2. Изучение языка предметной области

Понимание модели предметной области требует времени, терпения и заметок. Мы предварительно беседуем с нашими бизнес-экспертами и договариваемся о глоссарии и некоторых правилах для первой минимальной версии модели предметной области. Там, где это возможно, мы просим привести конкретные примеры, иллюстрирующие каждое правило.

Мы уверены, чтобы выразить эти правила на бизнес-жаргоне (на ubiquitous language в DDD терминологии) надо выбрать запоминающиеся идентификаторы для наших объектов, чтобы было легче говорить на примерах.

следующий сайдбар показывает некоторые заметки, которые мы могли бы сделать во время разговора с нашими экспертами по предметной области Распределения.

2.3. Модульное тестирование доменных моделей

Мы не собираемся показывать вам, как работает TDD в этой книге, но мы хотим показать вам, как мы могли бы построить модель из этого делового разговора.

Вот как может выглядеть один из наших первых тестов:

def test_allocating_to_a_batch_reduces_the_available_quantity():

batch = Batch("batch-001", "SMALL-TABLE", qty=20, eta=date.today())

line = OrderLine('order-ref', "SMALL-TABLE", 2)

batch.allocate(line)

assert batch.available_quantity == 18Название нашего модульного теста описывает поведение, которое мы хотим получить от системы, а имена классов и переменных, которые мы используем, взяты из делового жаргона. Мы могли бы показать этот код нашим нетехническим коллегам, и они согласились бы, что это правильно описывает поведение системы.

А вот и доменная модель, отвечающая нашим требованиям:

@dataclass(frozen=True) (1) (2)

class OrderLine:

orderid: str

sku: str

qty: int

class Batch:

def __init__(

self, ref: str, sku: str, qty: int, eta: Optional[date] (2)

):

self.reference = ref

self.sku = sku

self.eta = eta

self.available_quantity = qty

def allocate(self, line: OrderLine):

self.available_quantity -= line.qty (3)| 1 | OrderLine это неизменяемый класс данных без какого-либо поведения.[9] |

| 2 | Мы не показываем импорт в большинстве листингов кода, чтобы сохранить их в чистоте. Мы надеемся, что вы догадались, что это появилось здесь благодаря from dataclasses import dataclass; аналогично, typing.Optional и datetime.date. Если вы хотите что-то перепроверить, вы можете увидеть полный рабочий код для каждой главы в её ветке (например,

chapter_01_domain_model). |

| 3 | Аннотации типов по-прежнему вызывают споры в мире Python. Для моделей предметной области они иногда могут помочь прояснить или задокументировать ожидаемые аргументы, и люди с IDE часто благодарны за них. Вы можете решить, что цена, заплаченная с точки зрения удобочитаемости, слишком высока. |

Наша реализация здесь тривиальна: Batch просто декоратор! Берёт целое число available_quantity, и уменьшает это значение при резервровании товара в заказе. Мы написали кучу кода только для того, чтобы вычесть одно число из другого, но мы надеемся, что моделирование нашего домена точно окупится off.[10]

Давайте напишем несколько новых failing tests:

def make_batch_and_line(sku, batch_qty, line_qty):

return (

Batch("batch-001", sku, batch_qty, eta=date.today()),

OrderLine("order-123", sku, line_qty)

)

def test_can_allocate_if_available_greater_than_required():

large_batch, small_line = make_batch_and_line("ELEGANT-LAMP", 20, 2)

assert large_batch.can_allocate(small_line)

def test_cannot_allocate_if_available_smaller_than_required():

small_batch, large_line = make_batch_and_line("ELEGANT-LAMP", 2, 20)

assert small_batch.can_allocate(large_line) is False

def test_can_allocate_if_available_equal_to_required():

batch, line = make_batch_and_line("ELEGANT-LAMP", 2, 2)

assert batch.can_allocate(line)

def test_cannot_allocate_if_skus_do_not_match():

batch = Batch("batch-001", "UNCOMFORTABLE-CHAIR", 100, eta=None)

different_sku_line = OrderLine("order-123", "EXPENSIVE-TOASTER", 10)

assert batch.can_allocate(different_sku_line) is FalseЗдесь нет ничего неожиданного. Мы переработали наш набор тестов, чтобы не повторять одни и те же строки кода для создания партии товара (Batch) и позиции заказа (OrderLine) для одного и того же SKU; и мы написали четыре простых теста для нового метода can_allocate. Again, notice that the names we use mirror the language of our domain experts, and the examples we agreed upon are directly written into code.

Мы также можем реализовать это напрямую, написав can_allocate

метод Batch:

def can_allocate(self, line: OrderLine) -> bool:

return self.sku == line.sku and self.available_quantity >= line.qtyПока что мы можем управлять реализацией, просто увеличивая и уменьшая Batch.available_quantity, но когда мы перейдем к тестам deallocate(), мы будем вынуждены перейти к более интеллектуальному решению:

def test_can_only_deallocate_allocated_lines():

batch, unallocated_line = make_batch_and_line("DECORATIVE-TRINKET", 20, 2)

batch.deallocate(unallocated_line)

assert batch.available_quantity == 20В этом тесте мы assert-им, что deallocating (освобождение) строки из пакета не имеет никакого эффекта, если только пакет ранее не allocated (резервировал) эту позицию . Чтобы это сработало, наша Batch должна понять, какие позиции или строки были зарезервированы. Давайте посмотрим на реализацию:

class Batch:

def __init__(

self, ref: str, sku: str, qty: int, eta: Optional[date]

):

self.reference = ref

self.sku = sku

self.eta = eta

self._purchased_quantity = qty

self._allocations = set() # type: Set[OrderLine]

def allocate(self, line: OrderLine):

if self.can_allocate(line):

self._allocations.add(line)

def deallocate(self, line: OrderLine):

if line in self._allocations:

self._allocations.remove(line)

@property

def allocated_quantity(self) -> int:

return sum(line.qty for line in self._allocations)

@property

def available_quantity(self) -> int:

return self._purchased_quantity - self.allocated_quantity

def can_allocate(self, line: OrderLine) -> bool:

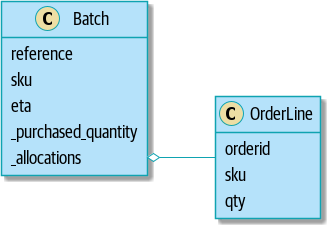

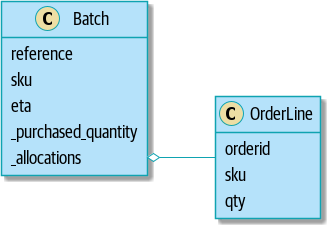

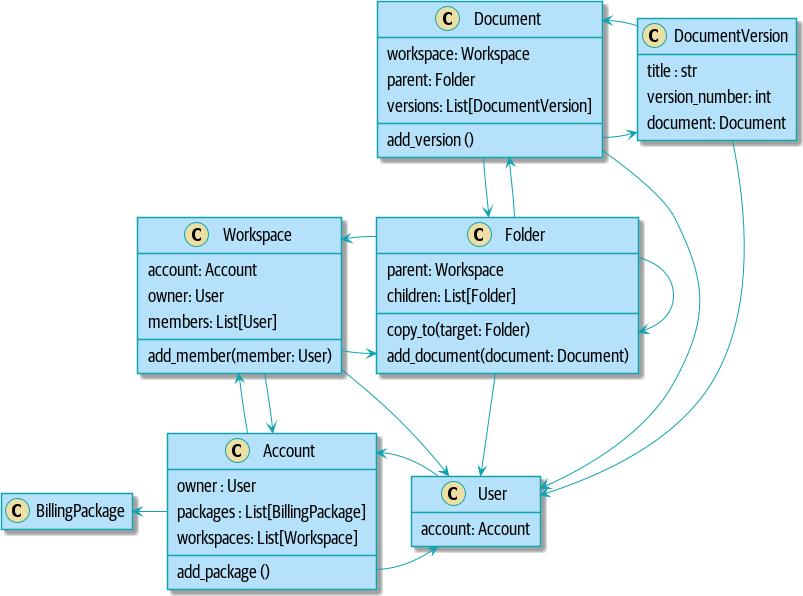

return self.sku == line.sku and self.available_quantity >= line.qtyOur model in UML показывает модель в UML.

[plantuml, apwp_0103, config=plantuml.cfg]

@startuml

scale 4

left to right direction

hide empty members

class Batch {

reference

sku

eta

_purchased_quantity

_allocations

}

class OrderLine {

orderid

sku

qty

}

Batch::_allocations o-- OrderLine

Теперь мы кое-чего добились! Партия товара(Batch) теперь отслеживает набор выделенных(allocated) объектов OrderLine. Когда мы распределяем (allocate), если у нас достаточно свободного количества(available quantity), мы просто добавляем к набору. Наше available_quantity теперь является вычисляемым свойством: купленное количество минус выделенное количество.

Да, мы могли бы сделать еще много. Немного обескураживает то, что и allocate(), и deallocate() могут потерпеть неудачу без предупреждения, но основа у нас теперь есть.

Кстати, использование набора для ._allocations упрощает нам обработку последнего теста, потому что элементы в наборе уникальны:

def test_allocation_is_idempotent():

batch, line = make_batch_and_line("ANGULAR-DESK", 20, 2)

batch.allocate(line)

batch.allocate(line)

assert batch.available_quantity == 18На данный момент, вероятно, будет обоснованной критикой сказать, что модель предметной области слишком тривиальна, чтобы беспокоиться о DDD (или даже об объектной ориентации!). В реальной жизни возникает множество бизнес-правил и крайних случаев: клиенты могут запросить доставку в определенные будущие даты, а это означает, что мы можем не захотеть распределять их на самую раннюю партию. Некоторые SKU (артикулы) не выпускаются партиями, а заказываются по требованию непосредственно у поставщиков, поэтому у них другая логика. В зависимости от местоположения клиента мы можем выделить только подмножество складов и отгрузок, которые находятся в его регионе, за исключением некоторых SKU, которые мы с удовольствием доставляем со склада в другом регионе, если у нас нет запасов в домашнем регионе. And so on. Настоящий бизнес в реальном мире знает, как нагромождать сложности быстрее, чем мы можем показать на странице!

Но взяв эту простую модель предметной области в качестве заменителя чего-то более сложного, мы расширим нашу простую модель предметной области в остальной части книги и подключим её к реальному миру API, баз данных и электронных таблиц. Мы увидим, как строгое следование нашим принципам инкапсуляции и тщательного проанализированного наслоения поможет нам избежать :) "говнокодинга"

2.3.1. Dataclasses отлично подходят для Value Objects

Мы широко использовали line в предыдущих листингах кода, но что такое строка? На нашем деловом языке order состоит из нескольких line товаров, где каждая строка имеет SKU и количество. Представм, что простой файл YAML, содержащий информацию о заказе, может выглядеть так:

Order_reference: 12345

Lines:

- sku: RED-CHAIR

qty: 25

- sku: BLU-CHAIR

qty: 25

- sku: GRN-CHAIR

qty: 25Обратите внимание, что в то время как заказ имеет reference, который однозначно идентифицирует его, line нет. (Даже если мы добавим ссылку на порядок в класс OrderLine, это не то, что однозначно идентифицирует саму строку.)

Всякий раз, когда у нас есть бизнес-концепция, имеющая данные, но не имеющая идентичности, мы часто предпочитаем представлять её с помощью шаблона Value Object. value object-это любой объект предметной области, который однозначно идентифицируется содержащимися в нем данными; обычно мы делаем их неизменяемыми:

@dataclass(frozen=True)

class OrderLine:

orderid: OrderReference

sku: ProductReference

qty: Quantity

Одна из приятных вещей, которые дают нам dataclasses (или namedtuples), — это value equality, что является причудливым способом сказать: "Две строки с одинаковыми orderid, sku и qty равны."

from dataclasses import dataclass

from typing import NamedTuple

from collections import namedtuple

@dataclass(frozen=True)

class Name:

first_name: str

surname: str

class Money(NamedTuple):

currency: str

value: int

Line = namedtuple('Line', ['sku', 'qty'])

def test_equality():

assert Money('gbp', 10) == Money('gbp', 10)

assert Name('Harry', 'Percival') != Name('Bob', 'Gregory')

assert Line('RED-CHAIR', 5) == Line('RED-CHAIR', 5)Эти ценностные объекты соответствуют нашему реальнму передставлению о том, как работают их ценности. Не имеет значения, о какой банкноте в 10 фунтов мы говорим, потому что все они имеют одинаковую ценность. Аналогично, два имени равны, если совпадают имя и фамилия; и две строки эквивалентны, если они имеют один и тот же заказ клиента, код продукта и количество. Однако мы все еще можем иметь сложное поведение на ценностном объекте. На самом деле, обычно поддерживают операции со значениями; например, математические операторы:

fiver = Money('gbp', 5)

tenner = Money('gbp', 10)

def can_add_money_values_for_the_same_currency():

assert fiver + fiver == tenner

def can_subtract_money_values():

assert tenner - fiver == fiver

def adding_different_currencies_fails():

with pytest.raises(ValueError):

Money('usd', 10) + Money('gbp', 10)

def can_multiply_money_by_a_number():

assert fiver * 5 == Money('gbp', 25)

def multiplying_two_money_values_is_an_error():

with pytest.raises(TypeError):

tenner * fiver2.3.2. Value Objects и Entities

Строка заказа однозначно идентифицируется по идентификатору заказа (ID), артикулу (SKU) и количеству (quantity); если мы изменим одно из этих значений, теперь у нас будет новая строка. Это определение value object: любой объект, который идентифицируется только своими данными и не имеет долгоживущей идентичности. А как насчет партии товара? Это is идентифицировано ссылкой.

Мы используем термин entity для описания объекта домена, который имеет долгосрочную идентичность. На предыдущей странице мы представили класс Name как объект значения. Если мы возьмем имя Гарри Персиваль и изменим одну букву, у нас будет новый объект Name, Барри Персиваль.

Должно быть ясно, что Гарри Персиваль не равен Барри Персивалю:

def test_name_equality():

assert Name("Harry", "Percival") != Name("Barry", "Percival")Но как насчет Гарри как личности? Люди меняют свои имена, семейное положение и даже пол, но мы продолжаем признавать их как одного человека. Это потому, что люди, в отличие от имен, имеют постоянное identity:

class Person:

def __init__(self, name: Name):

self.name = name

def test_barry_is_harry():

harry = Person(Name("Harry", "Percival"))

barry = harry

barry.name = Name("Barry", "Percival")

assert harry is barry and barry is harryСущности, в отличие от значений, обладают identity equality (равенством идентичности). Мы можем изменить их ценности, и они по-прежнему узнаваемы. Batches (партии), в нашем примере, являются сущностями. Мы можем выделить строки в заказе для партии товара или изменить дату, когда мы ожидаем, что она прибудет, и это будет все та же сущность.

Обычно мы делаем это явно в коде, реализуя операторы равенства для сущностей:

class Batch:

...

def __eq__(self, other):

if not isinstance(other, Batch):

return False

return other.reference == self.reference

def __hash__(self):

return hash(self.reference)

Магический метод Python __eq__

определяет поведение класса для == operator.[12]

И для объектов сущностей, и для объектов значений также стоит подумать о том, как __hash__ будет работать. Это волшебный метод, который Python использует для управления поведением объектов, когда вы добавляете их в наборы или используете их как ключи dict; вы можете найти дополнительную информацию в документации Python.

Для value objects хэш должен основываться на всех атрибутах value, и мы должны гарантировать, что объекты неизменяемы. Мы получаем это бесплатно, указав @frozen=True в классе данных.

Для сущностей самый простой вариант-сказать, что хэш-это None, что означает, что объект не является хэшируемым и не может, например, использоваться в множестве (имеется ввиду set). Если по какой-то причине вы решите, что действительно хотите использовать операции set или dict с сущностями, хэш должен основываться на атрибуте(атрибутах), таком как .reference, который определяет уникальную идентичность сущности с течением времени. Вы должны также попытаться как-то сделать этот атрибут read-only.

Это сложная территория; вы не должны изменять __hash__ без изменения __eq__. Если вы не уверены в том, что делаете, рекомендуется продолжить разбор почитав "Python Hashes and Equality" от нашего технического обозревателя Хайнека Шлавака - хорошее место для начала.

|

2.4. Не Все Должно быть Объектом: A Domain Service Function

Мы создали модель для представления партий, но на самом деле нам нужно распределить строки заказа по определенному набору партий, представляющих все наши запасы.

Иногда это просто не так.

Domain-Driven Design

Эванс обсуждает идею Domain Service operations, которые не имеют естественного дома в entity или value object.[13] То, что выделяет строку заказа для данного набора партий, очень похоже на функцию, и мы можем воспользоваться тем фактом, что Python - это многопарадигмальный язык, и просто сделать его функцией.

Давайте посмотрим, как мы можем протестировать такую функцию:

def test_prefers_current_stock_batches_to_shipments():

in_stock_batch = Batch("in-stock-batch", "RETRO-CLOCK", 100, eta=None)

shipment_batch = Batch("shipment-batch", "RETRO-CLOCK", 100, eta=tomorrow)

line = OrderLine("oref", "RETRO-CLOCK", 10)

allocate(line, [in_stock_batch, shipment_batch])

assert in_stock_batch.available_quantity == 90

assert shipment_batch.available_quantity == 100

def test_prefers_earlier_batches():

earliest = Batch("speedy-batch", "MINIMALIST-SPOON", 100, eta=today)

medium = Batch("normal-batch", "MINIMALIST-SPOON", 100, eta=tomorrow)

latest = Batch("slow-batch", "MINIMALIST-SPOON", 100, eta=later)

line = OrderLine("order1", "MINIMALIST-SPOON", 10)

allocate(line, [medium, earliest, latest])

assert earliest.available_quantity == 90

assert medium.available_quantity == 100

assert latest.available_quantity == 100

def test_returns_allocated_batch_ref():

in_stock_batch = Batch("in-stock-batch-ref", "HIGHBROW-POSTER", 100, eta=None)

shipment_batch = Batch("shipment-batch-ref", "HIGHBROW-POSTER", 100, eta=tomorrow)

line = OrderLine("oref", "HIGHBROW-POSTER", 10)

allocation = allocate(line, [in_stock_batch, shipment_batch])

assert allocation == in_stock_batch.referenceА наш сервис может выглядеть так:

def allocate(line: OrderLine, batches: List[Batch]) -> str:

batch = next(

b for b in sorted(batches) if b.can_allocate(line)

)

batch.allocate(line)

return batch.reference2.4.1. Магические методы Python позволяют нам использовать наши модели с идиоматическим Python

Вам может понравиться или не понравиться использование next() в предыдущем коде, но мы почти уверены, что вы согласитесь с тем, что возможность использовать sorted() в нашем списке партий — это хороший идиоматический Python.

Чтобы заставить его работать, мы реализуем __gt__ на нашей доменной модели:

class Batch:

...

def __gt__(self, other):

if self.eta is None:

return False

if other.eta is None:

return True

return self.eta > other.etaЭто прекрасно.

2.4.2. Исключения тоже могут выражать концепции предметной области

Имеется еще одна, наверное, последняя концепция, которую нужно охватить: исключения также могут использоваться для выражения концепций предметной области. В наших беседах с экспертами в предметной области мы узнали о возможности того, что заказ не может быть размещен, потому что у нас out of stock (нет запасов), и мы можем зафиксировать это, используя domain exception:

def test_raises_out_of_stock_exception_if_cannot_allocate():

batch = Batch('batch1', 'SMALL-FORK', 10, eta=today)

allocate(OrderLine('order1', 'SMALL-FORK', 10), [batch])

with pytest.raises(OutOfStock, match='SMALL-FORK'):

allocate(OrderLine('order2', 'SMALL-FORK', 1), [batch])Мы не будем слишком утомлять вас реализацией, но главное, что следует отметить, - это то, что мы тщательно называем наши исключения на ubiquitous language, так же как и наши сущности, объекты ценности и службы:

class OutOfStock(Exception):

pass

def allocate(line: OrderLine, batches: List[Batch]) -> str:

try:

batch = next(

...

except StopIteration:

raise OutOfStock(f'Нет в наличии для артикула {line.sku}')Наша модель предметной области в конце главы это визуальное представление того, где мы оказались.

Пожалуй, на сегодня хватит! У нас есть доменная служба, которую мы можем использовать для нашего первого варианта использования. Но сначала нам понадобится база данных…

3. Repository Pattern

Пришло время выполнить обещание использовать принцип инверсии зависимостей как способ отделить основную логику от инфраструктурных проблем.

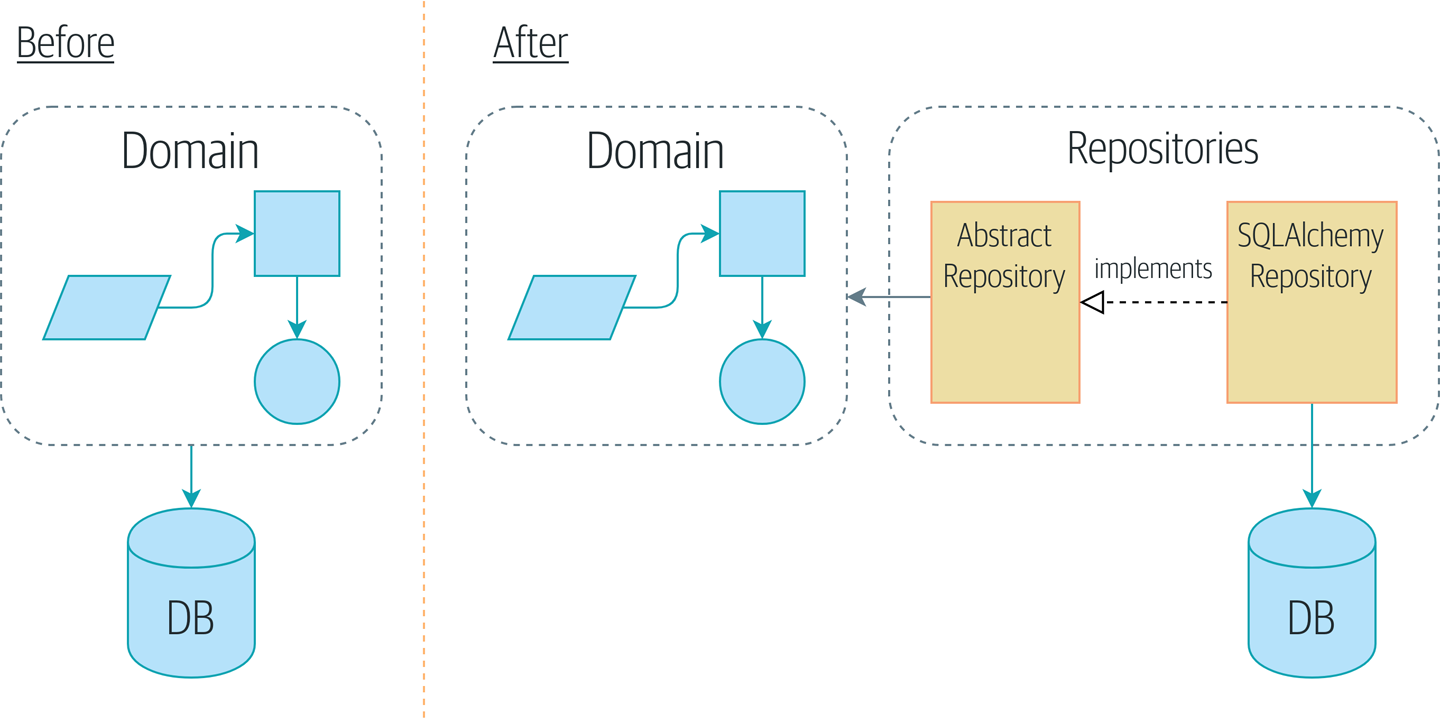

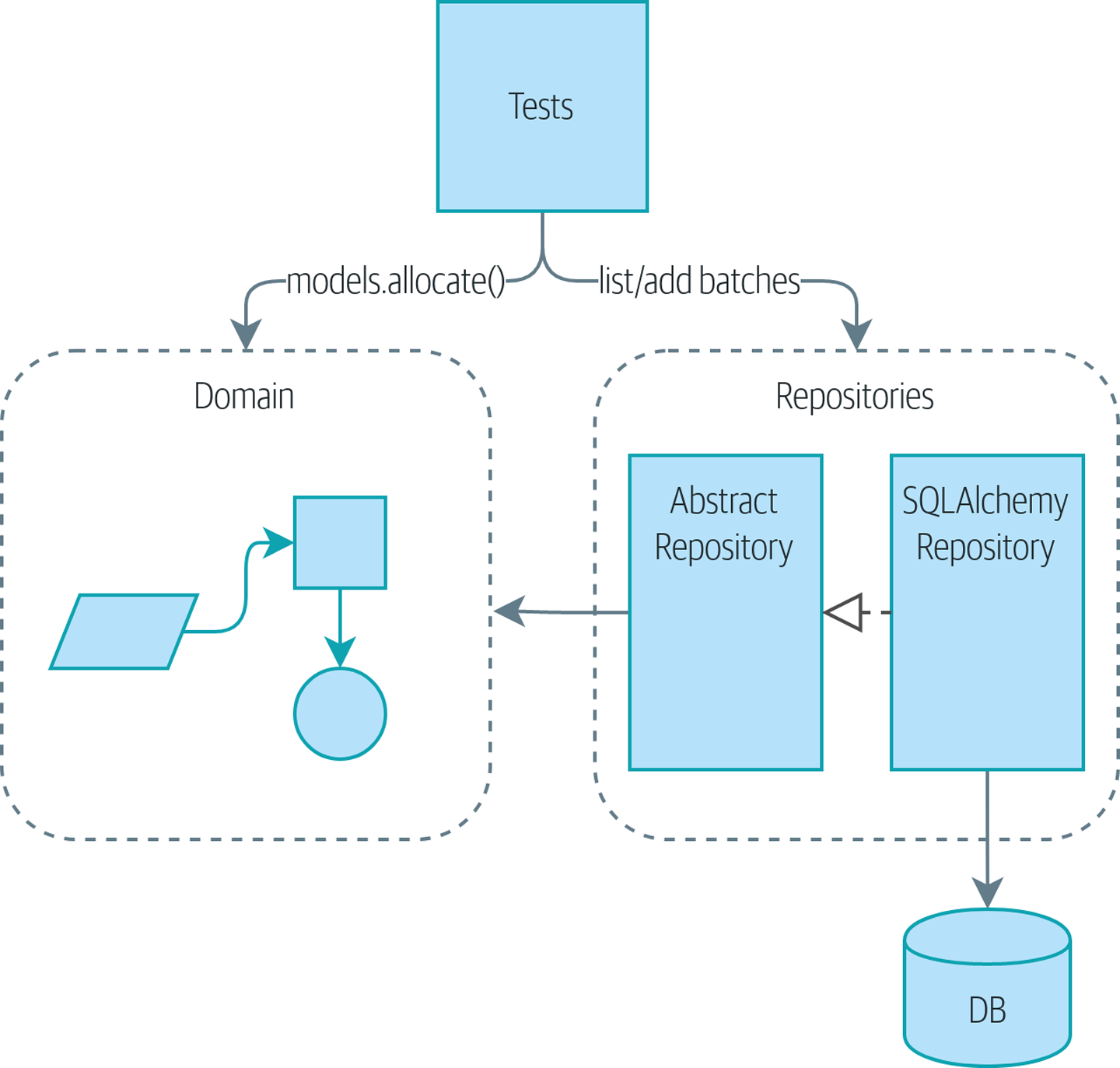

Представляем вам шаблон Repository, он упрощает абстракцию над хранилищем данных, позволяющую нам отделить слой модели от слоя данных. Давайте приведем конкретный пример того, как эта упрощающая абстракция делает нашу систему более тестируемой, скрывая сложности базы данных.

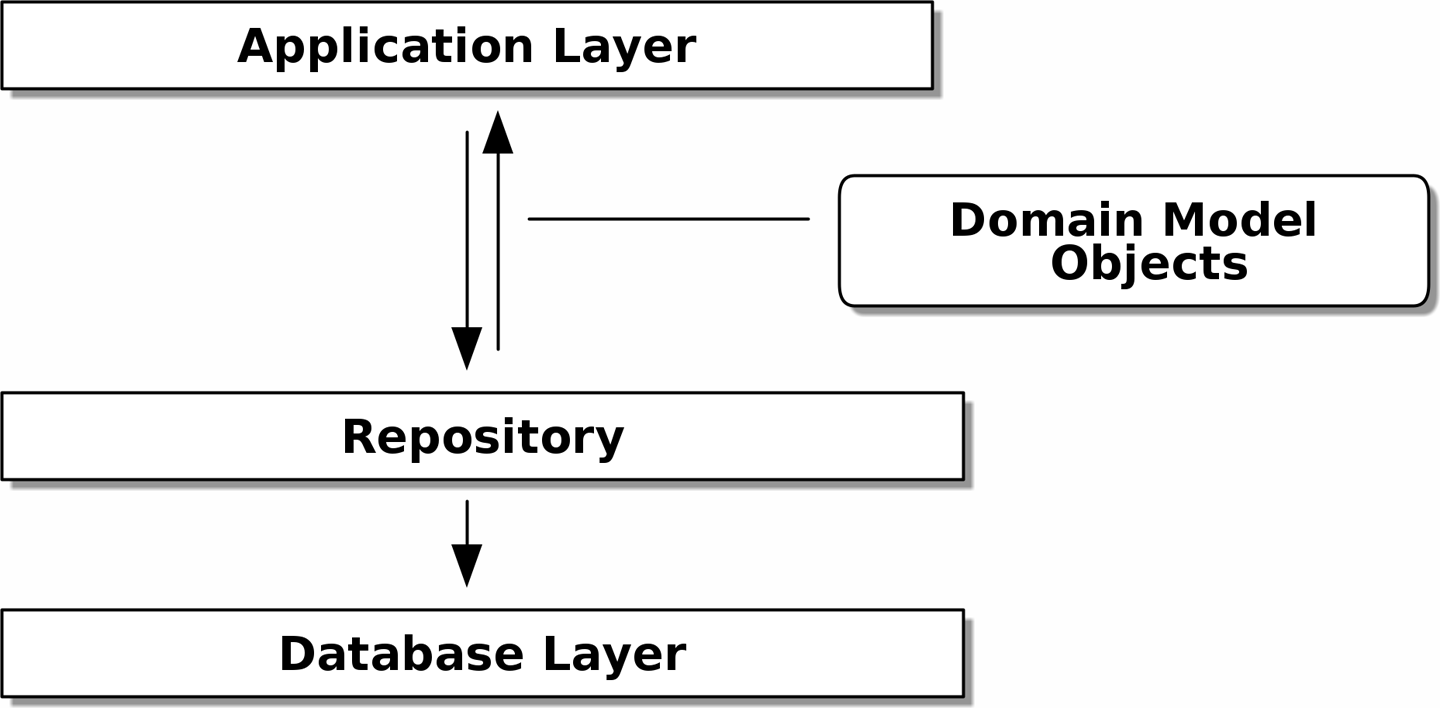

Картина До и после шаблона репозитория илюстрирует то, что мы собираемся построить: объект Repository, который находится между нашей моделью предметной области и базой данных.

|

Код для этой главы находится в chapter_02_repository branch on GitHub. git clone https://github.com/cosmicpython/code.git cd code git checkout chapter_02_repository # или чтобы писать код вместе с нами, ознакомьтесь с предыдущей главой: git checkout chapter_01_domain_model |

3.1. Persisting Our Domain Model

В Domain Modeling мы построили простую модель домена, которая может распределять заказы по партиям запасов. Мы относительно легко написали тесты для такого кода, потому что нет никаких зависимостей или инфраструктуры для настройки. Если бы нужно было запустить базу данных или API и создать тестовые данные, тесты было бы сложнее писать и поддерживать.

К сожалению, в какой-то момент нам придется передать эту идеальную маленькую модель в руки пользователей и бороться с реальным миром электронных таблиц, веб-браузеров и условий гонки. В следующих нескольких главах мы рассмотрим, как связать идеализированную модель предметной области с внешним состоянием.

В надежде на то, что мы будем работать гибко, наш основной приоритет — как можно быстрее получить минимально жизнеспособный продукт. В нашем случае это будет веб-API. В реальном проекте вы можете сразу погрузиться в несколько сквозных (end-to-end) тестов и начать подключать веб-фреймворк, тестируя функционал извне.

Но мы знаем, что, несмотря ни на что, нам понадобится какая-то форма постоянного хранения. Поскольку это учебник, мы можем позволить себе немного больше развития снизу вверх и начать думать о хранении и базах данных.

3.2. Псевдокод: Что делать то будем?

Когда мы создаём наш первый endpoint API, подразумеваем, что у нас будет некоторый код, который выглядит более или менее похожим на этот.

@flask.route.gubbins

def allocate_endpoint():

# извлечь строку заказа из запроса

line = OrderLine(request.params, ...)

# загрузить все партии из БД

batches = ...

# передать в domain service

allocate(line, batches)

# затем сохраните выделеные позици обратно в базу данных

return 201| Мы использовали Flask, потому что он достаточно простой, но вам не нужно быть с Flask на "ты", чтобы понять эту книгу. На самом деле, наша задача объяснить, как сделать выбор фреймворка незначительной деталью. |

Нам понадобится способ извлечения пакетной информации из базы данных и создания из нее экземпляров объектов модели домена, а также способ сохранения их обратно в базу данных.

Какого…? Ух-х-х, «gubbins» - это британское слово, означающее «фигня». Вы можете просто забить на это. Это’ж псевдокод, понятно?

3.3. Применение DIP для доступа к данным

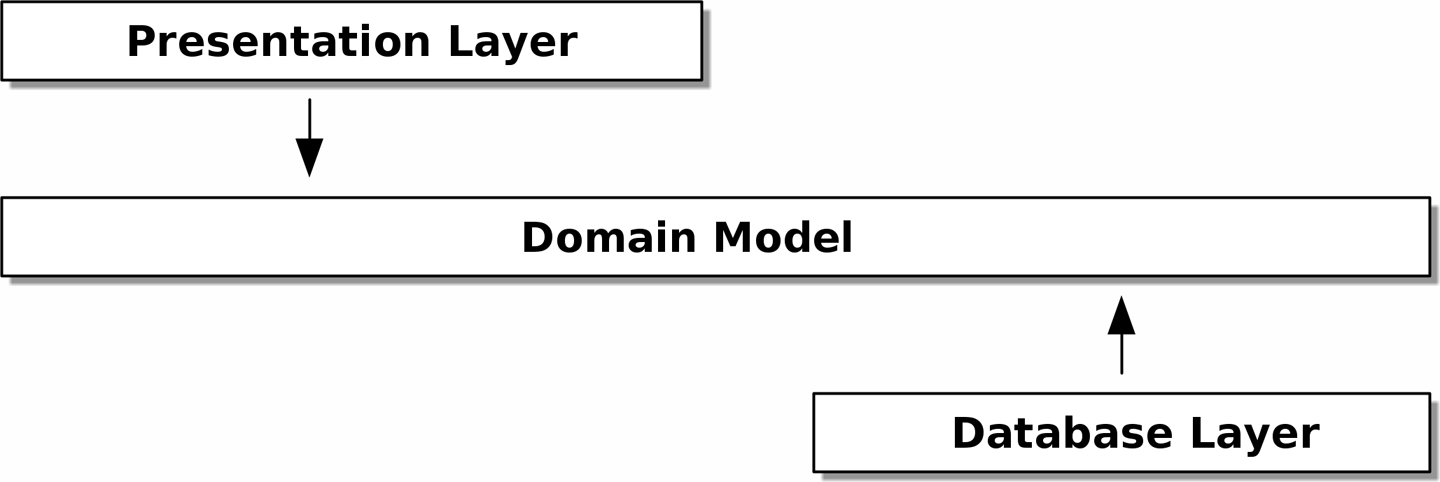

Как уже упоминалось в введение, многоуровневая архитектура — это общий подход к структурированию системы, которая имеет пользовательский интерфейс, некоторую логику и базу данных (см. Многослойная архитектура).

Структура Django Model-View-Template тесно связана, как и Model-View-Controller (MVC). В любом случае цель состоит в том, чтобы слои были разделены (что хорошо), и чтобы каждый слой зависел только от того, который находится под ним.

Надо, чтобы в нашей модели предметной области не было никаких зависимостей .[14] Не надо, чтобы проблемы с инфраструктурой проникли в нашу модель предметной области и замедлили наши модульные тесты или нашу способность вносить изменения.

Вместо этого, как обсуждалось во введении, мы будем думать, что наша модель находится "inside (внутри)", и зависимости текут внутрь неё; это то, что умные люди иногда называют onion (луковая) architecture (см. Onion architecture).

[ditaa, apwp_0203]

+------------------------+

| Presentation Layer |

+------------------------+

|

V

+--------------------------------------------------+

| Domain Model |

+--------------------------------------------------+

^

|

+---------------------+

| Database Layer |

+---------------------+

3.4. Напоминание: Наша модель

Давайте вспомним нашу модель предметной области (см. Наша модель):

Распределение - это концепция связывания OrderLine с Batch. Мы сохраняем выделенные позиици как коллекцию в нашем объекте Batch.

Давайте посмотрим, как мы можем перенести это в реляционную базу данных.

3.4.1. "Нормальный" способ это ORM: Модель зависит от ORM

В наши дни маловероятно, что члены вашей команды вручную создают свои собственные SQL-запросы. Вместо этого вы почти наверняка используете какой-то фреймворк для генерации строк SQL на основе ваших объектов модели.

Эти структуры называются объектно-реляционными картографами object-relational mappers (ОРМ), поскольку они существуют для преодоления концептуального разрыва между миром объектов и моделирования предметной области и миром баз данных и реляционной алгебры.

Самая важная вещь, которую дает нам ORM, - это игнорирование сохраняемости persistence ignorance: идея в том, что наша доменная модель не должна ничего знать о том, как данные загружаются или сохраняются. Это помогает сохранить наш домен чистым от прямых зависимостей конкретных технологий баз данных.[16]

Но если вы будете следовать типичному учебнику SQLAlchemy, то в итоге получите что-то вроде этого:

from sqlalchemy import Column, ForeignKey, Integer, String

from sqlalchemy.ext.declarative import declarative_base

from sqlalchemy.orm import relationship

Base = declarative_base()

class Order(Base):

id = Column(Integer, primary_key=True)

class OrderLine(Base):

id = Column(Integer, primary_key=True)

sku = Column(String(250))

qty = Integer(String(250))

order_id = Column(Integer, ForeignKey('order.id'))

order = relationship(Order)

class Allocation(Base):

...Вам не нужно разбираться в SQLAlchemy, чтобы увидеть, что наша изначальная модель теперь полна зависимостей от ORM и к тому же начинает выглядеть чертовски уродливо. Можно ли сказать, что эта модель игнорирует базу данных? Как это можно отделить от проблем с хранением, когда свойства нашей модели напрямую связаны со столбцами базы данных?

3.4.2. Инвертирование зависимости: ORM зависит от модели

К счастью, это не единственный способ использовать SQLAlchemy. Альтернативой является определение вашей схемы отдельно и определение явного mapper-а для преобразования между схемой и нашей моделью предметной области, что SQLAlchemy называет classical mapping:

from sqlalchemy.orm import mapper, relationship

import model (1)

metadata = MetaData()

order_lines = Table( (2)

'order_lines', metadata,

Column('id', Integer, primary_key=True, autoincrement=True),

Column('sku', String(255)),

Column('qty', Integer, nullable=False),

Column('orderid', String(255)),

)

...

def start_mappers():

lines_mapper = mapper(model.OrderLine, order_lines) (3)| 1 | ORM импортирует (или "зависит от" или "знает о") модель предметной области, а не наоборот. |

| 2 | Мы определяем таблицы и столбцы нашей базы данных с помощью абстракций SQLAlchemy.[17] |

| 3 | Когда мы вызываем функцию mapper, SQLAlchemy творит чудеса, связывая классы нашей модели предметной области с различными таблицами, которые мы определили. |

Конечным результатом будет то, что, если мы вызовем start_mappers, мы сможем легко загружать и сохранять экземпляры модели домена из базы данных и в нее. Но если мы никогда не вызываем эту функцию, наши классы доменных моделей остаются в блаженном неведении о базе данных.

Это дает нам все преимущества SQLAlchemy, включая возможность использовать alembic для миграций и возможность прозрачного запроса с использованием наших классов домена, как мы увидим.

Когда вы впервые пытаетесь создать свою конфигурацию ORM, может быть полезно написать для неё тесты, как в следующем примере:

def test_orderline_mapper_can_load_lines(session): (1)

session.execute(

'INSERT INTO order_lines (orderid, sku, qty) VALUES '

'("order1", "RED-CHAIR", 12),'

'("order1", "RED-TABLE", 13),'

'("order2", "BLUE-LIPSTICK", 14)'

)

expected = [

model.OrderLine("order1", "RED-CHAIR", 12),

model.OrderLine("order1", "RED-TABLE", 13),

model.OrderLine("order2", "BLUE-LIPSTICK", 14),

]

assert session.query(model.OrderLine).all() == expected

def test_orderline_mapper_can_save_lines(session):

new_line = model.OrderLine("order1", "DECORATIVE-WIDGET", 12)

session.add(new_line)

session.commit()

rows = list(session.execute('SELECT orderid, sku, qty FROM "order_lines"'))

assert rows == [("order1", "DECORATIVE-WIDGET", 12)]| 1 | Если вы не использовали pytest, то аргумент session для этого теста нуждается в объяснении. Смысл такой: Вам не нужно беспокоиться о деталях pytest или его фикстурах в целях этой книги, но главная мысль состоит в том, что вы можете определить общие зависимости для ваших тестов в виде "fixtures", и pytest передаст их в тесты, которые нуждаются в них, приняв их в качестве аргументов функций. В данном случае это сеанс session базы данных SQLAlchemy.

|

Вероятно, вам не стоит хранить эти тесты. Как вы вскоре увидите, после того, как поближе познакомитесь с инверсией зависимости ORM и модели предметной области, это всего лишь небольшой дополнительный шаг для реализации другой абстракции, называемой шаблоном репозитория, для которого будет легче писать тесты, и он предоставит простой интерфейс для, скажем так — фейка, позже в тестах.

Но мы уже достигли нашей цели инвертировать традиционную зависимость: модель предметной области остается «чистой» и свободной от инфраструктурных проблем. Мы могли бы выбросить SQLAlchemy и использовать другую ORM или совершенно другую систему сохранения, и модель предметной области вообще не нуждалась бы в изменении.

В зависимости от того, что вы делаете в своей модели предметной области, и особенно если вы отходите далеко от парадигмы объектно-ориентированного программирования, вам может оказаться все труднее заставить ORM обеспечить точное поведение, которое вам нужно, и вам может потребоваться изменить модель предметной области. [18] Как это часто бывает с архитектурными решениями, вам нужно будет найти компромисс. Как говорит дзэн Python: «Практичность лучше чистоты!»

На данный момент, однако, наш endpoint API может выглядеть примерно так, и мы могли бы заставить её работать просто отлично:

@flask.route.gubbins

def allocate_endpoint():

session = start_session()

# извлечение строки заказа из запроса

line = OrderLine(

request.json['orderid'],

request.json['sku'],

request.json['qty'],

)

# загрузите все пакеты из БД

batches = session.query(Batch).all()

# call our domain service

allocate(line, batches)

# сохраните распределения обратно в базу данных

session.commit()

return 2013.5. Знакомство с шаблоном репозитория

Шаблон Repository — это абстракция над постоянным хранилищем. Он скрывает скучные детали доступа к данным, делая вид, что все наши данные находятся в памяти.

Если бы у нас была бесконечная память в наших ноутбуках, у нас не было бы необходимости в неуклюжих базах данных. Вместо этого мы могли просто использовать наши объекты, когда нам заблагорассудится. Как это будет выглядеть?

import all_my_data

def create_a_batch():

batch = Batch(...)

all_my_data.batches.add(batch)

def modify_a_batch(batch_id, new_quantity):

batch = all_my_data.batches.get(batch_id)

batch.change_initial_quantity(new_quantity)Несмотря на то, что наши объекты находятся в памяти, нам нужно поместить их где-нибудь, чтобы снова найти их. Наши данные в памяти позволят нам добавлять новые объекты, как список или множество. Поскольку объекты находятся в памяти, нам никогда не нужно вызывать метод .save (); мы просто получаем объект, который нам нужен, и модифицируем его в памяти.

3.5.1. The Repository in the Abstract

В простейшем репозитории всего два метода: add () для добавления нового элемента в репозиторий и get() для возврата ранее добавленного элемента.[19]

Мы твердо придерживаемся использования этих методов для доступа к данным в нашем домене и на уровне сервиса. Эта добровольная простота не позволяет нам связать нашу модель предметной области с базой данных.

Вот как будет выглядеть абстрактный базовый класс (ABC) для нашего репозитория:

class AbstractRepository(abc.ABC):

@abc.abstractmethod (1)

def add(self, batch: model.Batch):

raise NotImplementedError (2)

@abc.abstractmethod

def get(self, reference) -> model.Batch:

raise NotImplementedError| 1 | Python tip: @abc.abstractmethod — это одна из немногих вещей, которая заставляет ABCs действительно "работать" в Python. Python не позволит вам создать экземпляр класса, который не реализует все "абстрактные методы", определенные в его родительском классе.[20]

|

| 2 | raise NotImplementedError — это хорошо, но это не обязательно и не достаточно. На самом деле, ваши абстрактные методы могут иметь реальное поведение, которое подклассы могут вызвать, если вы действительно хотите. |

3.5.2. Что такое компромисс?

Знаете, говорят, что экономисты знают всё о цене и ничего о ценности? Программисты же, знают всё о преимуществе и ничего о компромисе.

Всякий раз, когда мы представляем архитектурный паттерн в этой книге, мы всегда задаёмся вопроосом: «Что нам ЭТО даст? И во что нам ЭТО обойдётся?»

Обычно, вводя дополнительный уровень абстракции, мы по крайней мере надеемся, что это уменьшит сложность в целом, а в действительности всё это добавляет сложности локальной и имеет свою стоимость с точки зрения необработанного количества перемещений и текущего обслуживания.

Шаблон репозитория, вероятно, является одним из самых простых вариантов в книге, если вы уже идёте по пути DDD и инверсии зависимостей. Что касается нашего кода, на самом деле мы просто меняем абстракцию SQLAlchemy (session.query (Batch)) на другую (batches_repo.get), которую мы разработали.

Нам придется добавлять несколько строк кода в нашем классе репозитория каждый раз, когда мы добавляем новый объект домена, который мы хотим получить, но взамен мы получаем простую абстракцию над нашим уровнем хранения, который мы контролируем. Шаблон репозитория позволит легко вносить фундаментальные изменения в то, как мы храним объекты (см. Замена инфраструктуры: Делайте все с CSV), и, как мы увидим, его легко подменить для модульных тестов.

Кроме того, шаблон репозитория настолько распространен в мире DDD, что, если вы сотрудничаете с программистами, пришедшими в Python из мира Java и C#, они, скорее всего, узнают его. Repository pattern иллюстрирует этот паттерн.

[ditaa, apwp_0205]

+-----------------------------+

| Application Layer |

+-----------------------------+

|^

|| /------------------\

||----------| Domain Model |

|| | Objects |

|| \------------------/

V|

+------------------------------+

| Repository |

+------------------------------+

|

V

+------------------------------+

| Database Layer |

+------------------------------+

Как всегда, мы начинаем с теста. Это, вероятно, было бы классифицировано как интеграционный тест, поскольку мы проверяем, что наш код (репозиторий) правильно интегрирован с базой данных; следовательно, тесты, как правило, смешивают необработанный SQL с вызовами и ассертами в нашем собственном коде.

| В отличие от предыдущих тестов ORM, эти тесты являются хорошими кандидатами на то, чтобы оставаться частью вашей кодовой базы в долгосрочной перспективе, особенно если какие-либо части вашей модели предметной области означают, что объектно-реляционная карта нетривиальна. |

def test_repository_can_save_a_batch(session):

batch = model.Batch("batch1", "RUSTY-SOAPDISH", 100, eta=None)

repo = repository.SqlAlchemyRepository(session)

repo.add(batch) (1)

session.commit() (2)

rows = list(session.execute(

'SELECT reference, sku, _purchased_quantity, eta FROM "batches"' (3)

))

assert rows == [("batch1", "RUSTY-SOAPDISH", 100, None)]| 1 | repo.add() это тестируемый здесь метод. |

| 2 | Мы храним .commit() вне репозитория и возлагаем ответственность на вызывающего. В этом есть свои плюсы и минусы; некоторые из причин станут яснее, когда мы доберемся до Паттерн Unit of Work(Единица работы). |

| 3 | Используем необработанный SQL, чтобы убедиться, что были сохраненыправильные данные . |

Следующий тест включает в себя извлечение пакетов и распределений, поэтому он более сложный:

def insert_order_line(session):

session.execute( (1)

'INSERT INTO order_lines (orderid, sku, qty)'

' VALUES ("order1", "GENERIC-SOFA", 12)'

)

[[orderline_id]] = session.execute(

'SELECT id FROM order_lines WHERE orderid=:orderid AND sku=:sku',

dict(orderid="order1", sku="GENERIC-SOFA")

)

return orderline_id

def insert_batch(session, batch_id): (2)

...

def test_repository_can_retrieve_a_batch_with_allocations(session):

orderline_id = insert_order_line(session)

batch1_id = insert_batch(session, "batch1")

insert_batch(session, "batch2")

insert_allocation(session, orderline_id, batch1_id) (2)

repo = repository.SqlAlchemyRepository(session)

retrieved = repo.get("batch1")

expected = model.Batch("batch1", "GENERIC-SOFA", 100, eta=None)

assert retrieved == expected # Batch.__eq__ only compares reference (3)

assert retrieved.sku == expected.sku (4)

assert retrieved._purchased_quantity == expected._purchased_quantity

assert retrieved._allocations == { (4)

model.OrderLine("order1", "GENERIC-SOFA", 12),

}| 1 | Проверяет сторону чтения, поэтому необработанный SQL готовит данные для чтения repo.get(). |

| 2 | Избавляем вас от деталей insert_batch и insert_allocation; Зыдача в том, чтобы создать пару партий, а для интересующей нас партии выделить одну существующую строку заказа. |

| 3 | Вот что мы здесь проверяем. Первый assert == проверяет соответствие типов и совпадение ссылок (потому что, как вы помните, Batch — это сущность, и для нее у нас есть собственный __ eq __ ). |

| 4 | Поэтому мы также явно проверяем его основные атрибуты, в том числе

._allocations, который представляет собой набор Python-объектов значений OrderLine. |

Независимо от того, насколько вы кропотливо написали тесты для каждой модели. После того, как у вас будет протестирован один класс на создание/изменение/сохранение, вы можете продолжить и протестировать другие с минимальным тестом на обратную связь или вообще ничего, если все они следуют схожему шаблону. В нашем случае конфигурация ORM, которая устанавливает набор ._allocations, немного сложна, поэтому заслуживает особого тестирования.

Вы получите что-то вроде этого:

class SqlAlchemyRepository(AbstractRepository):

def __init__(self, session):

self.session = session

def add(self, batch):

self.session.add(batch)

def get(self, reference):

return self.session.query(model.Batch).filter_by(reference=reference).one()

def list(self):

return self.session.query(model.Batch).all()И теперь наша конечная точка Flask может выглядеть примерно так:

@flask.route.gubbins

def allocate_endpoint():

batches = SqlAlchemyRepository.list()

lines = [

OrderLine(l['orderid'], l['sku'], l['qty'])

for l in request.params...

]

allocate(lines, batches)

session.commit()

return 2013.6. Создание поддельного репозитория для тестов теперь тривиально!

Вот одно из самых больших преимуществ шаблона репозиторий:

class FakeRepository(AbstractRepository):

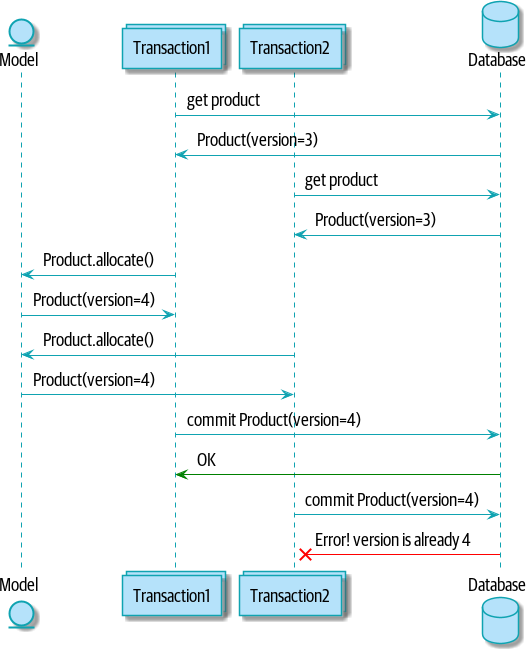

def __init__(self, batches):